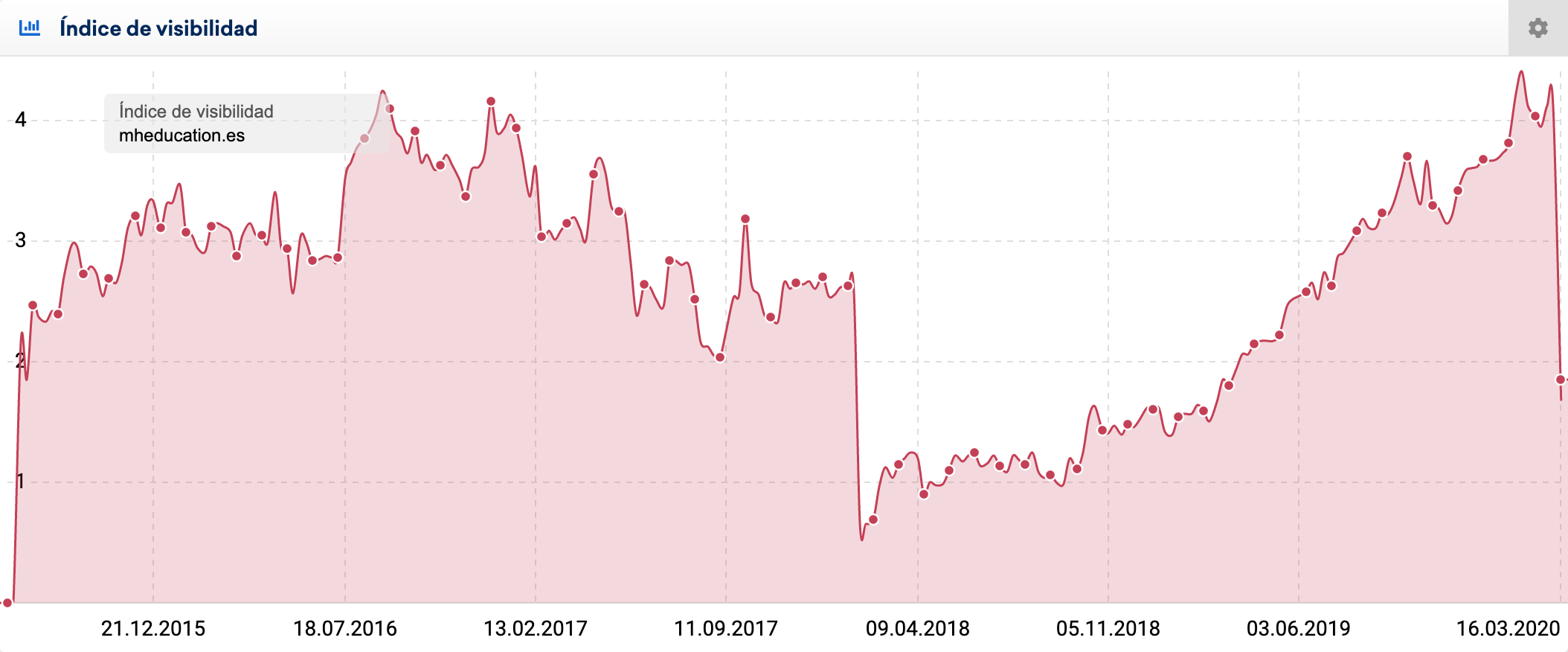

Con el gráfico de visibilidad muchas veces encontramos caídas o subidas en el índice que nos pueden ayudar a identificar incidencias (positivas o negativas). Este artículo explica cómo ir tirando del hilo con los datos de SISTRIX para identificar qué ha pasado, ¡vamos allá!

Para este articulo vamos a usar tres ejemplos diferentes: varias caídas repentinas y una bajada de visibilidad tras una migración.

Caída repentina: ¿Por dónde empezamos?

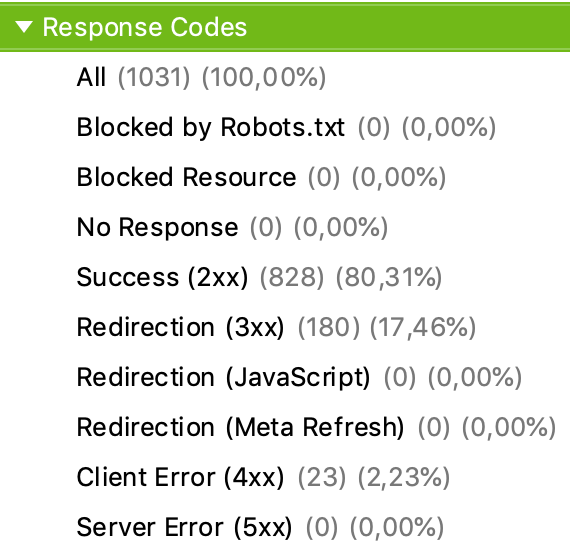

Os pongo en antecedentes: nos ponemos a revisar la visibilidad del proyecto y nos encontramos lo siguiente:

¿Por dónde podemos empezar? Pues como os podréis imaginar deberíamos chequear lo más restrictivo en cuanto a directivas y situaciones que un proyecto SEO puede albergar:

- ¿La web está disponible, responde con un código de estado 200 (Ok) o está caída (código de estado 500) o no está disponible (código de estado 404)?

- ¿Existen directivas que impiden la indexación o que fomentan la desindexación? Etiqueta Noindex o por cabeceras Http.

- ¿Existe un bloqueo del rastreo? Por ejemplo, mirando robots.txt

- Ante tecnologías basadas en Javascript, ¿Google puede representar gráficamente el contenido?

- ¿Hemos recibido algún aviso a través de Google Search Console sobre penalizaciones manuales?

En el caso de Redalyc.org, el proyecto está basado en Angular Javascript. Por lo que ya podríamos empezar a revisar si Google es capaz de representar de forma gráfica y correcta el contenido.

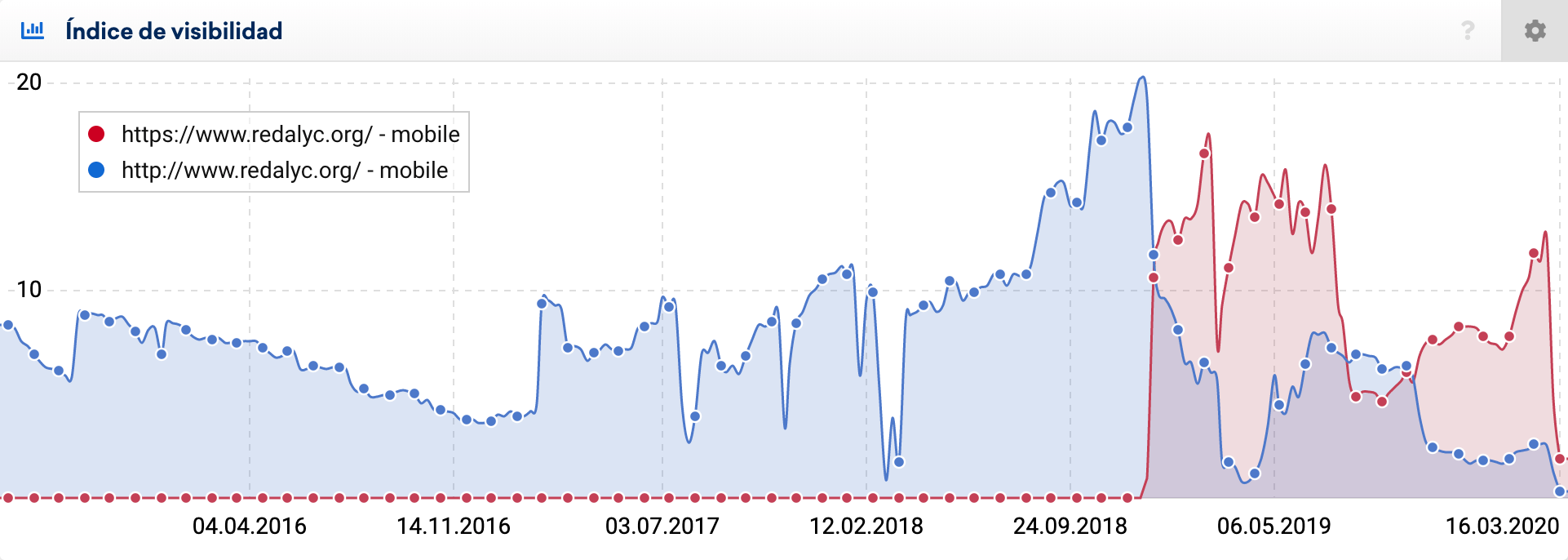

Podemos usar OPTIMIZER para rastrear el sitio web con el mismo User-Agent que usa Google y así, tener un análisis ya más profundo.

Podemos usar la herramienta Mobile Friendly Test de Google para identificar si es capaz o no de renderizar, con el objeto de saber si puede ser ese el problema.

Para webs basadas en Frameworks Javascript hay una solución más compleja y costosa que es implementar SSR, es decir, que el servidor entregue el HTML ya representado gráficamente.

La alternativa más sencilla sería implementar Dynamic Rendering. Podéis consultar la documentación de Google aquí.

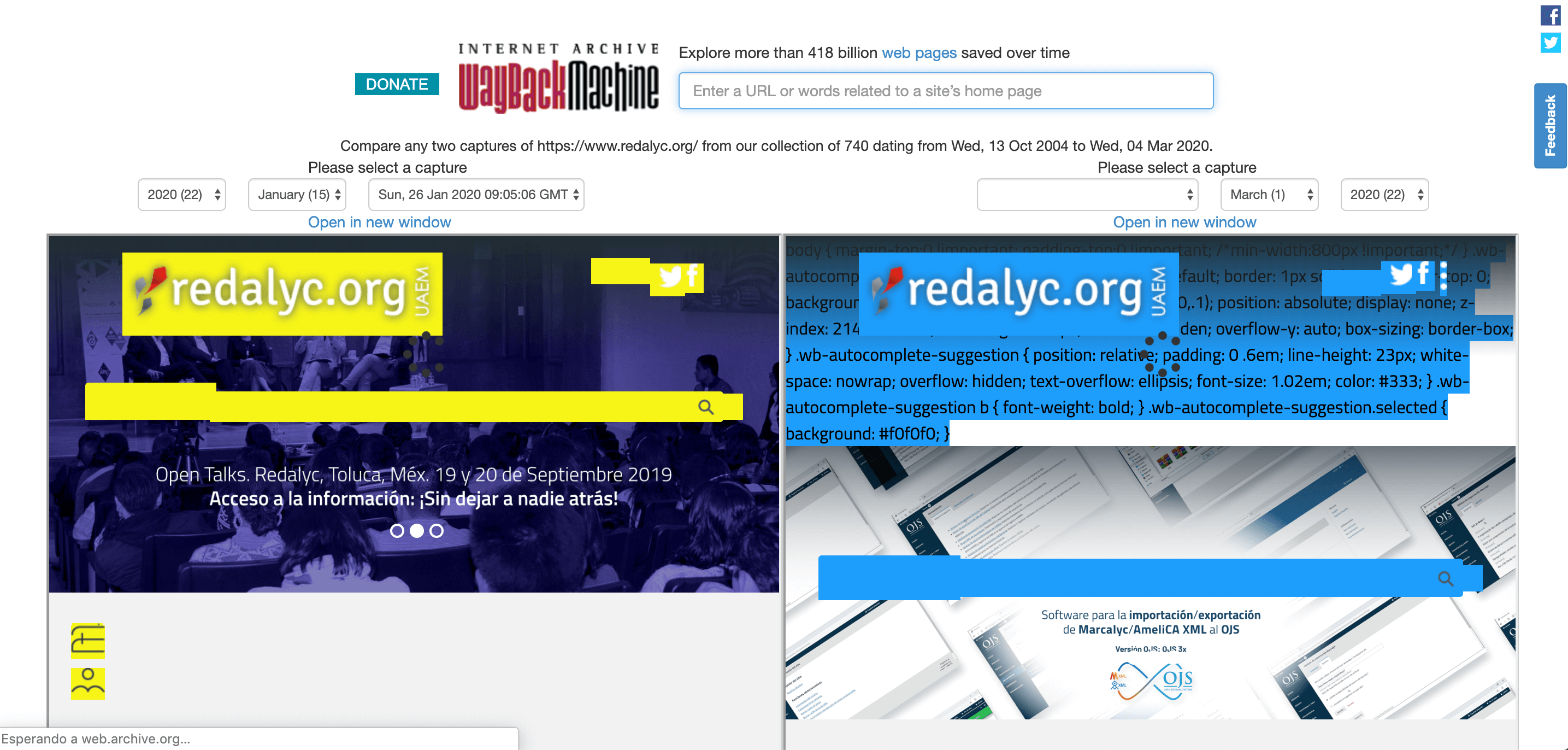

Fijaos que usando la opción Changes, de Wayback Machinne, podemos ver qué cambios han ocurrido entre dos fechas. Desde esta URL podéis elegir las dos fechas y al darle a comparar, veréis los cambios resaltados tal que así:

¿Pero ya podemos concluir que esto es lo que le ha pasado a Redalyc?

No tan rápido, lo veremos en el siguiente punto :)

En el caso de motofan.com, tan solo intentando entrar en la web vemos que no carga o tarda demasiado y el navegador no nos devuelve el contenido. Si Google está intentando acceder y le ocurre lo mismo… Pues las consecuencias ya las sabéis…

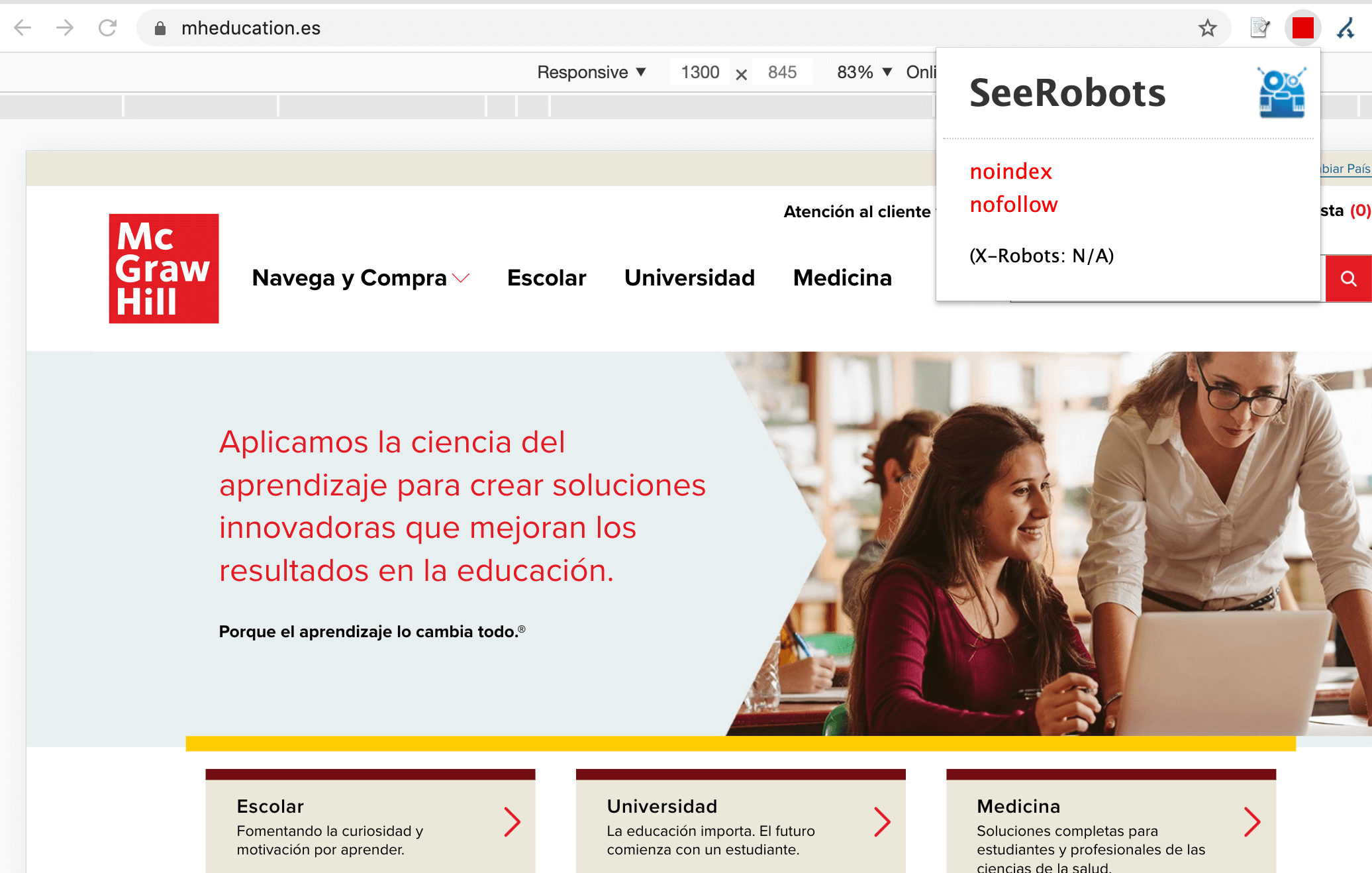

Por último, otro caso fácil y evidente de caída repentina de visibilidad es mheducation.es

Tan solo visitando la web y teniendo activo el Plug-In SeeRobots vemos que existe un problema con las instrucciones meta-robots, dado que está establecido como NOINDEX:

Se está produciendo una desindexación de URLs, solo tendríamos que identificar en cuántas URLs se ha añadido por error esta instrucción y eliminarla o modificarla por INDEX. La reflexión aquí también está en POR QUÉ ha sucedido. Pero lo importante es identificarlo y tratar de resolverlo.

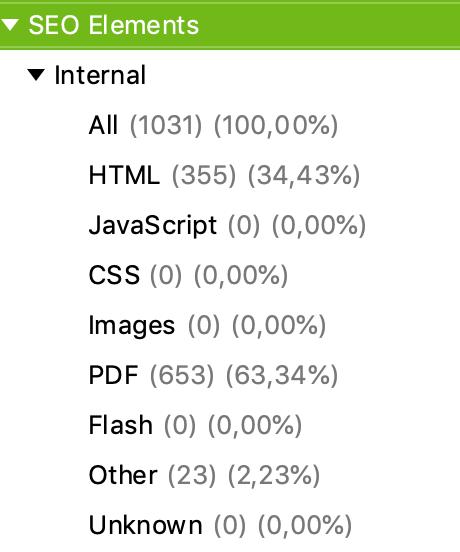

De lo general a lo particular

En paralelo, en SISTRIX tenemos varias formas de ver si ha afectado a una parte de la web o a la web al completo.

La primera opción es revisar si todos los subdominios y directorios, y comprobar si han tenido o no el mismo impacto.

Por otro lado, podemos hacer uso también de una potente funcionalidad que es «Cambios en el Ranking» para identificar qué rankings hemos perdido o cuáles han salido del top 10 de Google.

Para el caso de Redalyc, he revisado qué palabras clave estaban en el top 100 en fecha 2 de marzo y ya no lo están en fecha 16 de marzo

Me he descargado todas las URLs de los rankings perdidos para ver si esas URLs devuelven un código de estado 404 o no y, seguir investigando.

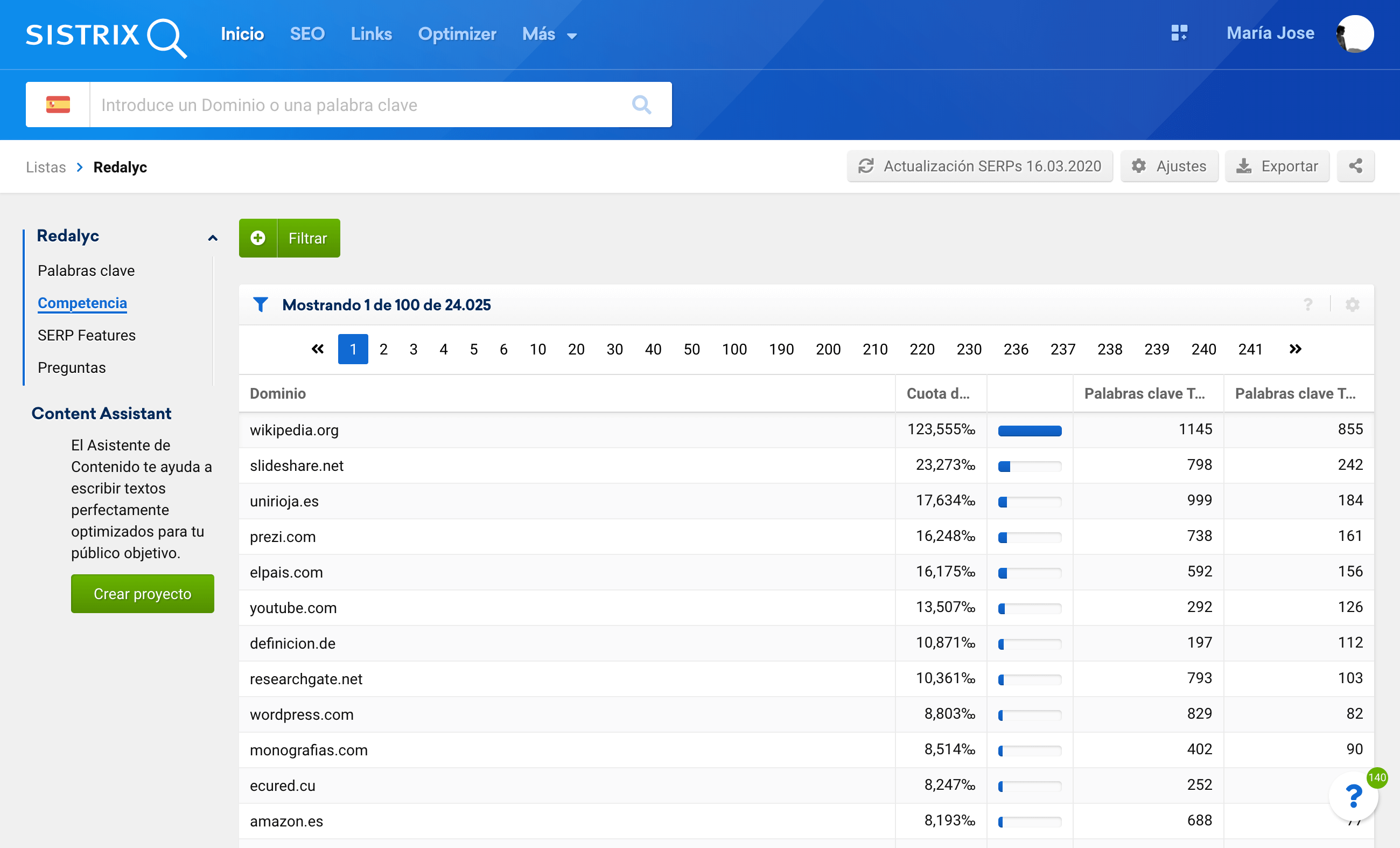

Y además, no se observa que haya un cambio masivo de URLs ni eliminación de las mismas. Por lo que se han movido 180 PDFs al protocolo Https:

Si os fijáis en el desglose de directorios, podéis ver fácilmente que el cambio lo hicieron en enero. Por lo que estos PDFs son casos puntuales que han ocurrido ahora:

En total, ¿qué he encontrado? Que el 80% de las URLs que pierden posicionamiento son PDFS:

¿Puede que los PDF no sean la mejor respuesta para determinadas palabras clave? Habría que estudiarlo a fondo pero usando las listas podemos ver dónde han ido a parar los rankings perdidos y seguir uniendo puntos.

Con este aspecto sumado al tema de Render Javascript, tendríamos ya 2 áreas en las que investigar en profundidad.

Una migración ¿mal hecha?

En el capítulo de migraciones, con SISTRIX es fácil identificar los cambios de dominio o rediseño, como ya hicimos el artículo de El Palacio de la Plata o el de Aki y Leroy Merlín.

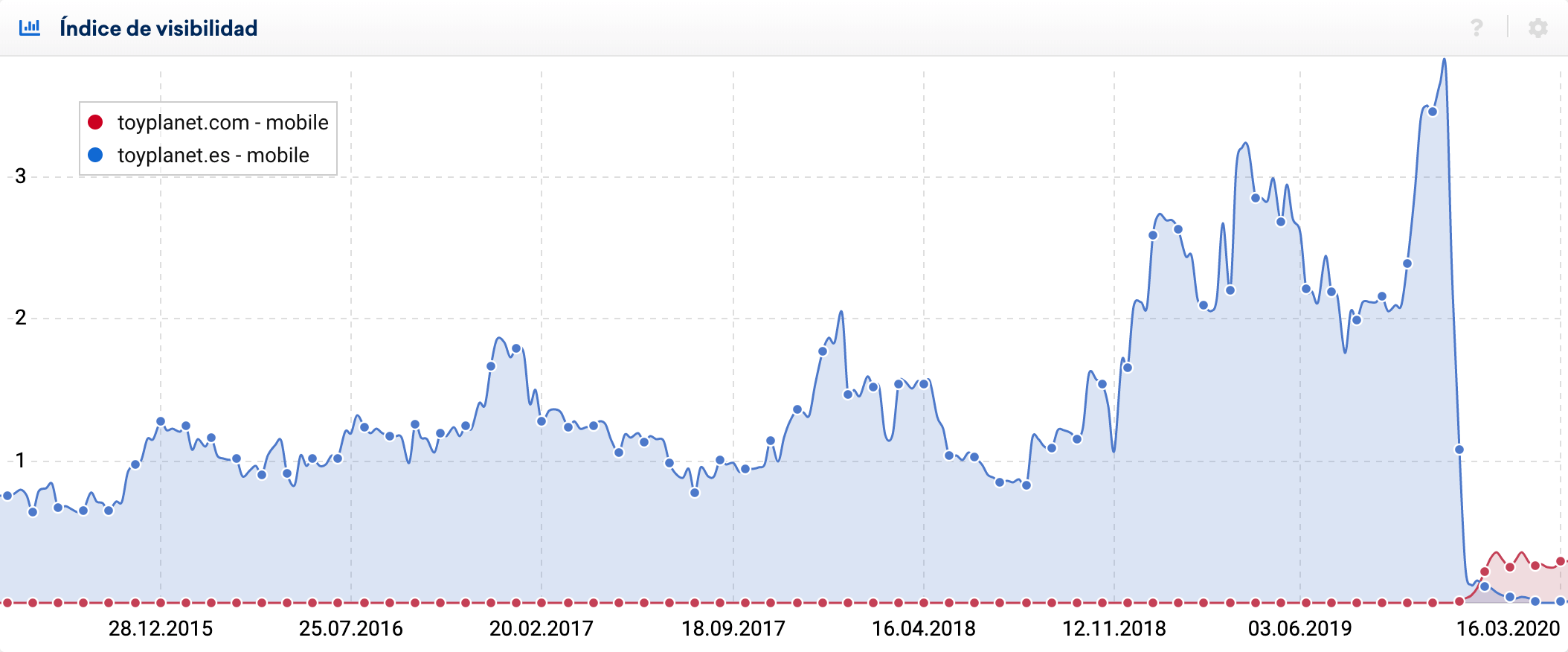

Para este ejemplo he revisado el caso de Toy Planet, que migró su sitio de .es a .com:

En estos casos, se suele hacer una planificación exhaustiva meses antes del lanzamiento. En este caso concreto, se trata de un cambio de dominio y el paso a la tecnología e-commerce de Salesforce.

¿Qué comprobaciones deberíamos acometer para identificar si hemos hecho algo mal una vez que ya hemos migrado? Pues a grandes rasgos:

- Comprobar las redirecciones y si Google puede acceder correctamente tanto desde User-Agent para dispositivo móvil como para dispositivo de escritorio.

- Aspectos técnicos: velocidad de carga, meta-robots, canonical, robots.txt, Sitemaps, profundidad de los enlaces, …

- Aspectos de relevancia: comprobar si han habido grandes cambios en estructura y contenido de las páginas, etiquetados, datos estructurados, jerarquía de las páginas, …

- Monitorización de las métricas principales en cada área SEO: rastreo con los logs, indexación total y por secciones, visitas y páginas que reciben tráfico orgánico, rankings, impresiones y clics, etc.

Podéis ampliar la información al respecto en este artículo sobre migraciones.

Con lo que tengo a mi alcance (los rankings) no he encontrado nada concluyente que me haga pensar que está mal ejecutada. Sin embargo, revisando la fecha en la que el dominio .es empieza a caer, no coincide con la fecha en la que migran. Por lo que cabría una hipótesis: ¿cayó antes de migrar?

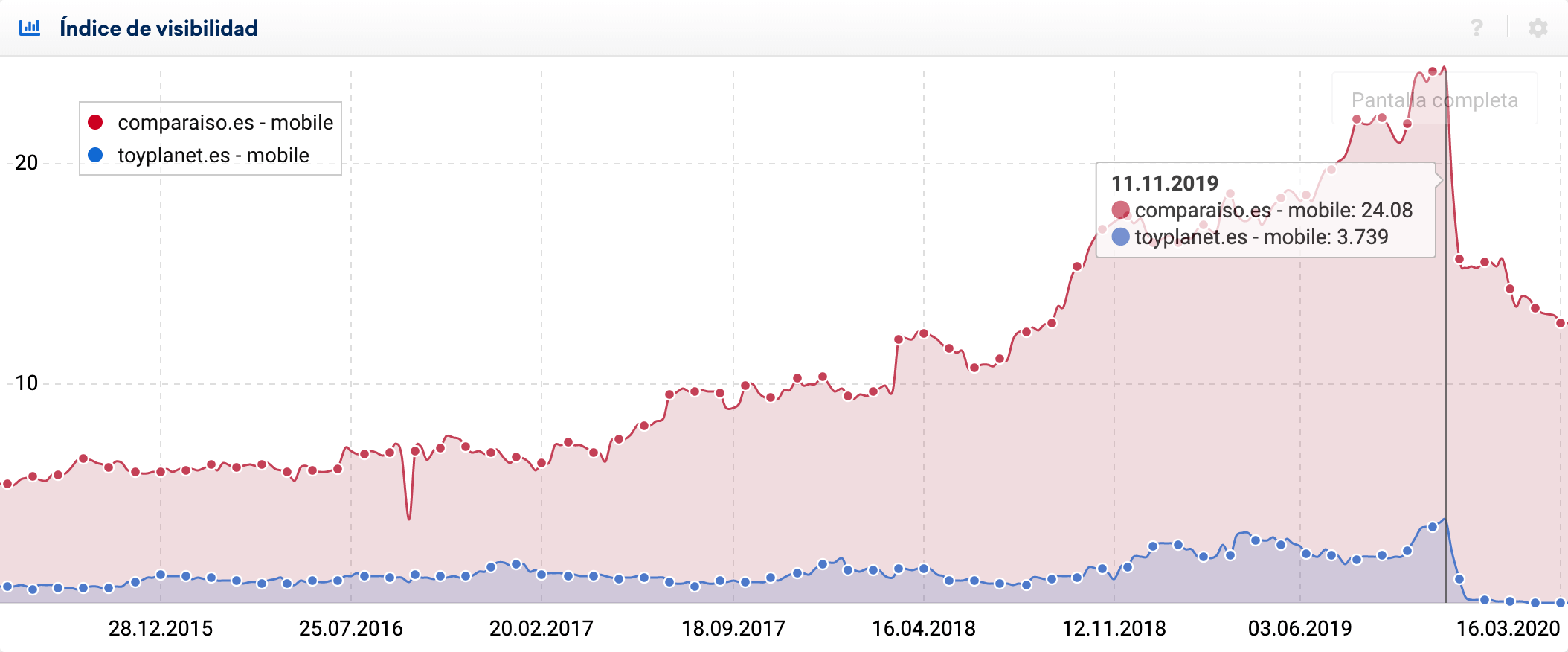

Si nos fijamos en la fecha, 11/11/2019, esa semana hubo rumores de un posible cambio de algoritmo que Google nunca confirmó.

Si comparamos la visibilidad con alguna de las páginas web que en esas fechas sufrieron una gran caída, podríamos tener una hipótesis extra que no tiene nada que ver con la migración:

Conclusiones y aprendizajes

En general, para analizar caídas de visibilidad, uno de los indicios de un problema SEO, necesitamos más datos para tener una serie de hipótesis sólidas y bien planteadas. Datos como por ejemplo:

- Datos de rastreo: páginas que reciben hits (cada petición que se hace al servidor solicitando un archivo) totales, agrupadas por segmentos (tipo de página, tipo de contenido, tipo de intención, aporte en negocio, etc). Añadir datos de cobertura de Google Search Console.

- Datos de indexación: páginas indexadas totales, agrupadas por segmentos (tipo de página, tipo de contenido, tipo de intención, aporte en negocio, etc). Añadir datos de cobertura de Google Search Console.

- Datos de rendimiento: métricas de velocidad de carga por tipo de página y por dispositivo. Así como evolutivos, basados en una periodicidad temporal (diaria, semanal, mensual).

- Datos de visibilidad y tráfico: índice de visibilidad, nº de palabras clave posicionadas, nº de URLs posicionadas. Todo distribuido por subdominios, directorios y URLs. Lo mismo con el número de visitas con segmentos de valor para el negocio (tipo de página, intención, profundidad, ….). Añadir datos de impresiones, clics y CTR.

- Datos de SERPs: distribución de formatos y características, características por intención y, quizás cruzar esto con datos de CTR de Google Search Console.

Nuestro principal aprendizaje es que, salvo en los casos evidentes como el Noindex o las páginas web cuyo servidor no responde, en el resto de casos no podemos afirmar con certeza qué ha motivado la caída. Pero si podemos ver la punta del iceberg para seguir escarbando hacia las profundidades del problema que ha motivado la caída y con datos, quizás llegar a contemplar la magnitud de la situación al completo.

Podemos decir que no ha sido un momento muy afortunado el que ha hecho que coincida una migración con una actualización de Google. Y quizás, podemos considerar los indicios que se observan para afirmar que la caída comienza antes de la migración, pero sin poder revisar el resto de datos que comentaba, solo son suposiciones.

También podemos mencionar el hecho de usar Frameworks Javascript implica un alto esfuerzo en entender cómo Google procesa, accede y representa el contenido gráficamente, y las implicaciones que puede tener esto tanto en la elección de la tecnología, los impactos en SEO y en el negocio. Y por supuesto, la experiencia final que experimentará el usuario.

Por finalizar, comentar que existe un sesgo cognitivo llamado «sesgo de confirmación», que consiste en «favorecer, buscar, interpretar y recordar la información que confirma las propias creencias o hipótesis, dando desproporcionadamente menos consideración a posibles alternativas». Tengamos la responsabilidad y la precaución de no incurrir en conclusiones que no puedan ser demostradas con datos o, al menos, que no sean fruto de valorar/ comprobar varias hipótesis alternativas. La reflexión, el análisis y la autocrítica nos llevará a ser mejores profesionales.