Detrás de los sitios web grandes hay muchos conocimientos técnicos. Nosotros en SISTRIX siempre nos hemos comprometido a compartir conocimiento singular sobre SEO de primera mano. Cuatro expertos en SEO españoles, que se ocupan de los sitios web de las principales compañías, te brindan conocimientos exclusivos sobre SEO para grandes proyectos.

- ¿Qué habilidades debe tener un SEO para trabajar en grandes proyectos?

- ¿Tiene o no tiene sentido trabajar con agencias o consultores externos?

- SEO en grandes proyectos: ¿Qué departamentos deben saber qué?

- ¿Cómo se ve el futuro del SEO para grandes proyectos?

- ¿Qué estrategias se recomiendan para el rastreo e indexación de sitios web grandes?

- ¿Cuál es el beneficio de desindexar grandes cantidades de páginas?

- ¿Cómo manejo y controlo el robot de Google en páginas web grandes?

- ¿Qué estrategias puedo utilizar para abastecer a cientos o incluso millones de páginas con enlaces internos?

- ¿Cómo cambia una marca fuerte, con sus búsquedas por marca, la investigación de palabras clave?

- ¿Cómo se organiza la asignación del material de palabras clave existente a los formatos y cómo se evita una canibalización de palabras clave de los formatos individuales entre sí?

- ¿Cómo se puede escalar, descubrir y cultivar «Evergreen – Content»?

- ¿Qué tan importante es la búsqueda interna? ¿Qué se puede aprender de esto?

- ¿Qué consejos tenéis para el A/B Test?

- ¿Qué condiciones se deben cumplir en los sitios web grandes para que sea posible una internacionalización con Hreflang?

- ¿Cómo se mantiene la visión general y cuando se desciende a nivel de palabras clave individuales?

Descubre cómo SISTRIX puede ayudarte a mejorar tu posicionamiento en buscadores. Accede gratis durante 14 días a todos los datos y funciones, sin compromiso y sin costes ocultos: Probar SISTRIX gratis

Cuando se trata de SEO para páginas web grandes, Carlos Redondo, Pedro Martinez, Lakil Essady y Daniel Pinillos, nos hablan de su propia experiencia. Llevan trabajando en SEO desde hace años y han asesorado en múltiples proyectos y saben, por lo tanto, qué medidas SEO implementar en o para grandes empresas.

¿Qué habilidades debe tener un SEO para trabajar en grandes proyectos?

Cuando hablamos del equipo perfecto SEO debemos hablar también de un buen líder SEO. Un buen líder SEO debe tener una sólida comprensión del SEO técnico y entender la infraestructura de una web grande.

Un buen SEO no necesita «esa única» habilidad especial. Los especialistas técnicos y de contenido son indispensables pero la optimización exitosa de los motores de búsqueda siempre tiene en cuenta la visión general.

En sitios web extensos, puede ser útil contar con equipos especializados en diferentes campos.

¿Tiene o no tiene sentido trabajar con agencias o consultores externos?

Una ventaja clave de trabajar con agencias es la visión externa de las cosas en una empresa. Está claro que nadie conoce su propio sitio web y la estructura técnica, así como el SEO inhouse de una empresa. Sin embargo, solo conoce el caso número 1. Las agencias, sin embargo, ya han guiado muchos proyectos y han ganado una fuerte experiencia, conocen las oportunidades y los riesgos que quizás no vea como propios el/la inhouse.

Los Skill-Sets se vuelven cada vez más nichos y el trabajo SEO se vuelve más especializado: conseguir un consultor SEO puede ser útil.

Las empresas no agrupan todos los recursos técnicos en la propia empresa. Si se requiere experiencia, trabajar con una agencia especializada es la mejor opción y también brinda una valiosa oportunidad para cuestionar su propia estrategia. Ésto hace que las agencias sean una importante incorporación al ecosistema del marketing digital.

SEO en grandes proyectos: ¿Qué departamentos deben saber qué?

El trabajo de un SEO siempre se relaciona con otras áreas de una empresa. La más importante es una buena comunicación entre los diferentes departamentos. Si todo el mundo en la empresa conoce el «mantra básico» del SEO, ya se ha dado un paso importante.

Los SEOs deberían dedicar más tiempo a escuchar a otros departamentos, en lugar de hablarles.

Las empresas exitosas entienden SEO no como un departamento, sino como un proceso y como un canal para atraer clientes potenciales, conversiones y ventas. Con este reconocimiento, el SEO obtendrá la atención que merece en la empresa.

¿Cómo se ve el futuro del SEO para grandes proyectos?

En el último vídeo nuestros invitados echan un vistazo a la bola de cristal SEO. Veremos un aumento constante en las nuevas disciplinas de SEO a medida que avance la tecnología, similar a lo que está experimentando actualmente la búsqueda por voz. Por lo tanto, los SEOs serán cada vez más especializados y ocuparán nichos, o al menos deberían de.

Es muy probable que a día de hoy solo podamos estar haciendo la mitad de las cosas que se nos podría exigir en cinco años.

SEO para grandes sitios web es un tema interesante, pero ¿cómo solucionan los expertos SEO los problemas técnicos en un sitio web extenso?

¡Vamos a preguntarles! Consultamos a SEOs de Alemania, Gran Bretaña y España y les hicimos preguntas específicas en este contexto.

Junto a nuestros invitados españoles Carlos Redondo, Pedro Martinez, Lakil Essady y Daniel Pinillos tomaron la palabra desde Alemania Dominik Schwarz, Daniel Reeh, Benedikt Kirch, Nedim Šabić y Markus Hövener. Cómo se resuelven las cosas en Reino Unido nos lo aclaran Kirsty Hulse, Alex Moss, Stephen Kenwright y Patrick Langridge.

¿Qué estrategias se recomiendan para el rastreo e indexación de sitios web grandes?

La primera pregunta en términos de rastreo e indexación debería ser: ¿Qué páginas/URLs realmente necesitas y cuáles no? Nuestros expertos coinciden en que la pensada creación de contenido es una poderosa palanca para rastrear e indexar de manera fiable.

Daniel Reeh

meinestadt.de

Contenido de la web: tanto como sea necesario, tan poco como sea posible.

Un problema común con el rastreo e indexación es el contenido duplicado que se ha creado debido a los filtros y otros parámetros. Aquí ayuda externalizar los parámetros tanto como sea posible en las cookies y no dejar que Google rastree. Los filtros y las navegaciones facetadas aún se pueden implementar bien a través del patrón PRG.

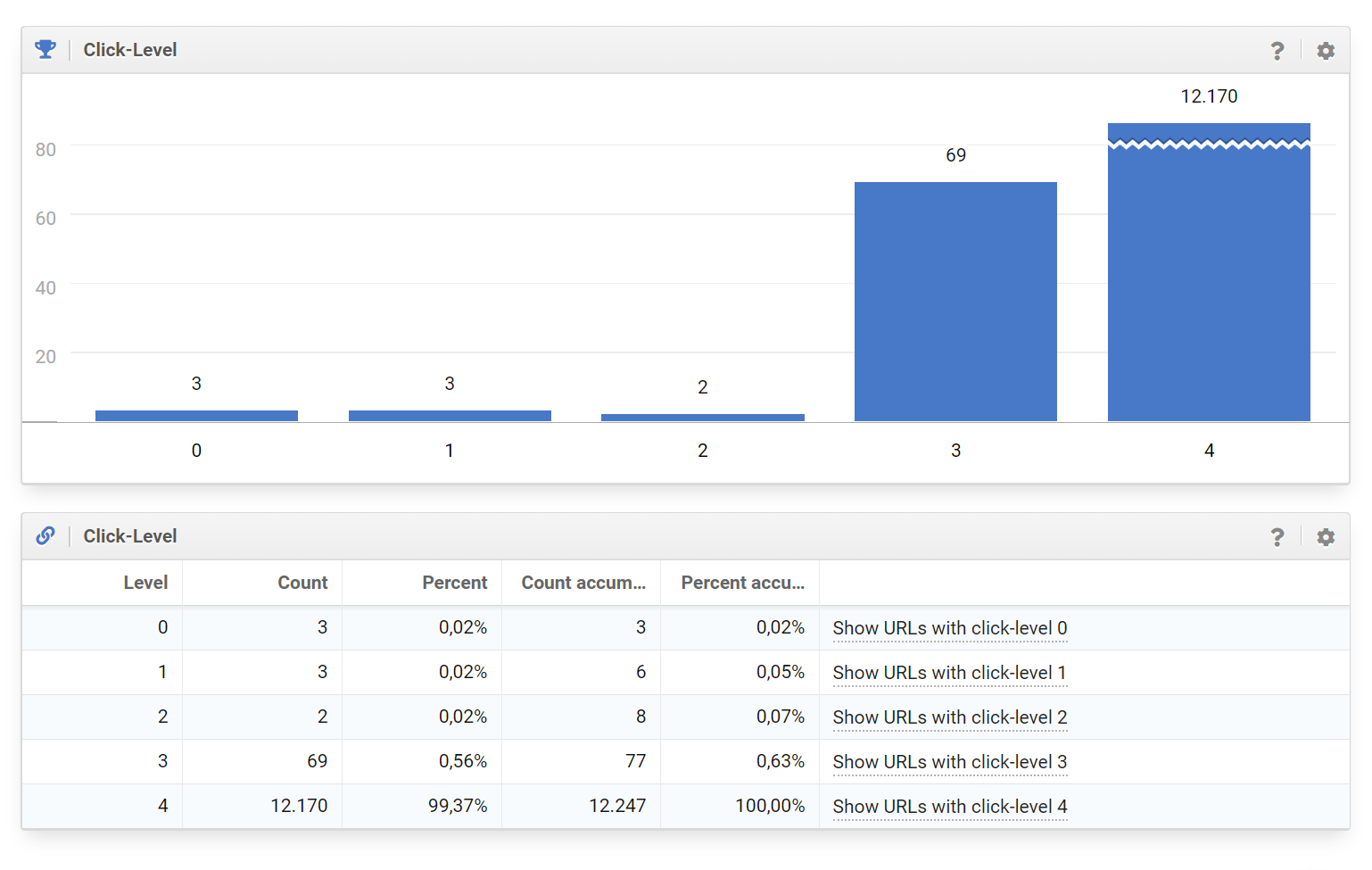

Además, uno debe estar atento a la profundidad de clics de sus propias páginas. Cuanto más profundo es el contenido más tiempo tarda el robot de Google en encontrarlo.

Especialmente para sitios web grandes, una división en grupos por temas ha demostrado ser de utilidad. Dado que ya no es posible ver y revisar todas las páginas individualmente para sitios web grandes, la vinculación interna y entre los grupos debe estructurarse sistemáticamente.

El uso de XML, imágenes, vídeos y Sitemaps ayuda al robot de Google a entender una página. Estos archivos nunca se deben crear a mano en sitios web extensos, sino siempre de forma algorítmica.

¡También la velocidad de carga de la página es un factor! Con tiempos de carga más rápidos, el robot de Google puede encontrar más contenido al mismo tiempo usando los mismos recursos.

En resumen, no hay una solución general para ningún sitio web grande. Sin embargo, a partir de cierto tamaño es indispensable comprender tu propio sistema y controlarlo.

¿Cuál es el beneficio de desindexar grandes cantidades de páginas?

Desindexar un gran número de páginas de tu propio dominio puede traer beneficios. Aquí también, nuestros expertos recomiendan una estrategia bien pensada.

Si se pregunta si ciertas páginas o secciones enteras de una página web no están indexadas en el índice de Google, el niño ya ha caído en el pozo. Especialmente con las entradas creadas editorialmente, una revisión puede valer la pena antes de desindexar el contenido.

Dominik Schwarz

hometogo.de

Uno debería elegir entre «desindexación» y «ni siquiera crear

La eliminación de partes grandes e innecesarias de una página web puede también mejorar las señales del resto de las páginas. Idealmente, después de una desindexación a gran escala solo quedarán páginas que se han clasificado internamente como necesarias y, por lo tanto, que tienen una calidad superior a la media.

Si el contenido hiperdinámico del sitio web ha encontrado su camino en el índice, puede excluirse de la indexación. La situación es similar con los parámetros y la paginación. En primer lugar, tiene sentido mapear los cambios técnicamente limpios usando su propio sistema. Además, el atributo noindex solo afecta a la indexación, no el rastreo de la página.

El uso de etiquetas de Google, como compartir «noindex» y «follow», pueden ser una herramienta efectiva a corto plazo pero debe evitarse. Aquí uno depende del procesamiento de estas señales por parte de Google, que puede cambiar en cualquier momento.

Por último, pero no menos importante, una reducción en las páginas existentes puede dar como resultado un enlazado interno más fuerte y simplificado, lo que a su vez beneficia el rastreo del robot de Google.

¿Cómo manejo y controlo el robot de Google en páginas web grandes?

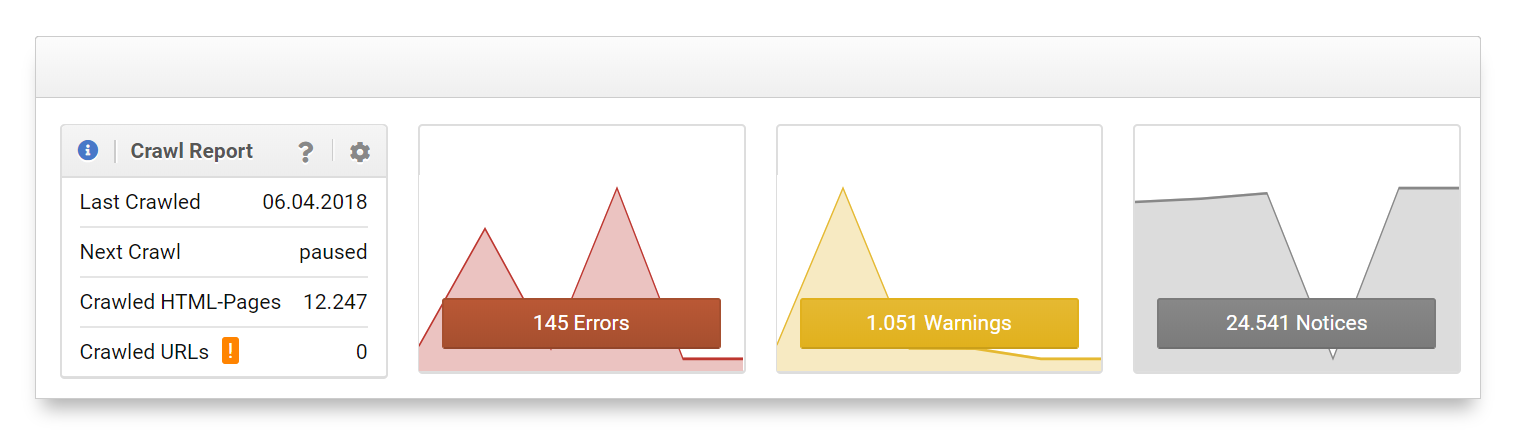

Tan pronto como un sitio web ha alcanzado el nivel del que se puede hablar de un sitio web grande, el control y la monitorización del robot de Google ganan importancia.

La Google Search Console proporciona información importante sobre el comportamiento de rastreo del robot de Google en su propia página. Google proporciona información útil en las estadísticas de rastreo sobre cuántas subpáginas del dominio se rastrearon en un día. Por ejemplo, si hay 1.000.000 de URLs en un dominio pero Google solo rastrea 20.000 páginas/ día, un rastreo completo puede llevar mucho tiempo.

Patrick Langridge

screamingfrog.co.uk

Con una arquitectura de información bien pensada, Googlebot es más fácil de controlar que el archivo robots.txt. Crea una ruta lógica a través de las páginas, lo que tiene sentido tanto para los usuarios como para los motores de búsqueda.

Para sitios web extensos también es recomendable analizar sus propios archivos de registro del servidor, ya que están mucho más actualizados que en Search Console. Tiene sentido trabajar con las alertas para las desviaciones de las métricas previamente definidas, ya que la cantidad de entradas en los registros ya no se pueden gestionar manualmente.

Si no se ha pensado en evaluar los archivos de registro del servidor de un sitio web grande, puede valer la pena comenzar con una pila-ELK. Esta es una combinación de Elastic Search, Logstash y Kibana, con la que se recopilan, almacenan y evalúan los archivos de registro.

Lakil Essady

crawlo.com

No todo lo que dicen los Logs es correcto. Por lo tanto, es importante prestar especial atención a cuál es el verdadero Googlebot y cuál no.

Otra posibilidad: simular el robot de Google a través de un rastreador externo que se ejecute en la página. De este modo los problemas, que pueden impedir que Google rastree o lo limite, se vuelven rápidamente visibles.

¿Qué estrategias puedo utilizar para abastecer a cientos o incluso millones de páginas con enlaces internos?

Los enlaces internos son especialmente importantes para los sitios web con muchas subpáginas para guiar a los usuarios y, por supuesto, al robot de Google a través del propio sitio. No existe una solución general para enlazar cientos de miles o millones de páginas con enlaces internos. Está claro que se requiere una solución automatizada, a esta escala.

¿Está dividido su contenido para que por ejemplo pueda dividirse en sus propios silos? ¿O tiene sentido ampliar la navegación, por ejemplo, con la ayuda de un mega-menú?

Ambas variantes permiten, de diferentes formas, conectar automáticamente un gran número de páginas con enlaces internos. En ambos casos, es importante establecer objetivos estratégicos claros.

Stephen Kenwright

branded3.com

Una estrategia obvia es utilizar una ruta de navegación, así como encabezados y pies de página.

Al decidir qué páginas tienen más probabilidades de estar vinculadas internamente, los valores de Analytics también pueden ser una herramienta de toma de decisiones. En primer lugar, vincula los tipos de página con alto tráfico.

Otras dos estrategias útiles son: los enlaces internos al «estilo de Wikipedia» y la provisión automática de enlaces a páginas similares y adicionales, por ejemplo, en la barra lateral de un artículo.

¿Qué obstáculos aparecen a menudo en la implementación técnica?

La implementación de un plan de acción es un desafío para los sitios web de todos los tamaños. Esto tiene aún más sentido para los sitios web grandes. Por esta razón, hemos pedido a nuestros expertos que informen sobre obstáculos que a menudo ven en una implementación técnica.

A menudo, hay una falta de capacidad técnica: si no se planifican los recursos para el departamento de IT puede conducir rápidamente a que los planes no se implementen por completo o al menos, no dentro del marco de tiempo planificado.

Benedikt Kirch

obi.de

Por último, se debe especificar para cada tipo de página qué medidas de SEO deberían funcionar. Esto no solo hace que sea más fácil para IT obtener rápidamente una visión general de las medidas ya implementadas, sino también para sí mismo.

Dos clásicos en lo que respecta a errores en la implementación técnica faltan días o están incorrectamente establecidos. Ya sea el Hreflang o la clara definición de una versión canónica usando «canonicals».

Curiosamente, el punto más infravalorado es la comunicación: los grandes sitios web a menudo tienen grandes organizaciones con muchas personas involucradas en el proceso de producción. El dicho «muchos cocineros estropean las gachas», desafortunadamente es demasiado bueno.

Una buena herramienta son los procedimientos automatizados. Por ejemplo: en forma de Unit-Tests para garantizar que todo funcione según lo previsto, antes y después de cada lanzamiento. En el desarrollo ágil los SEO-Checkpoints han demostrado ser un medio eficaz: los posibles obstáculos se podrán detectar pronto.

¿Cómo cambia una marca fuerte, con sus búsquedas por marca, la investigación de palabras clave?

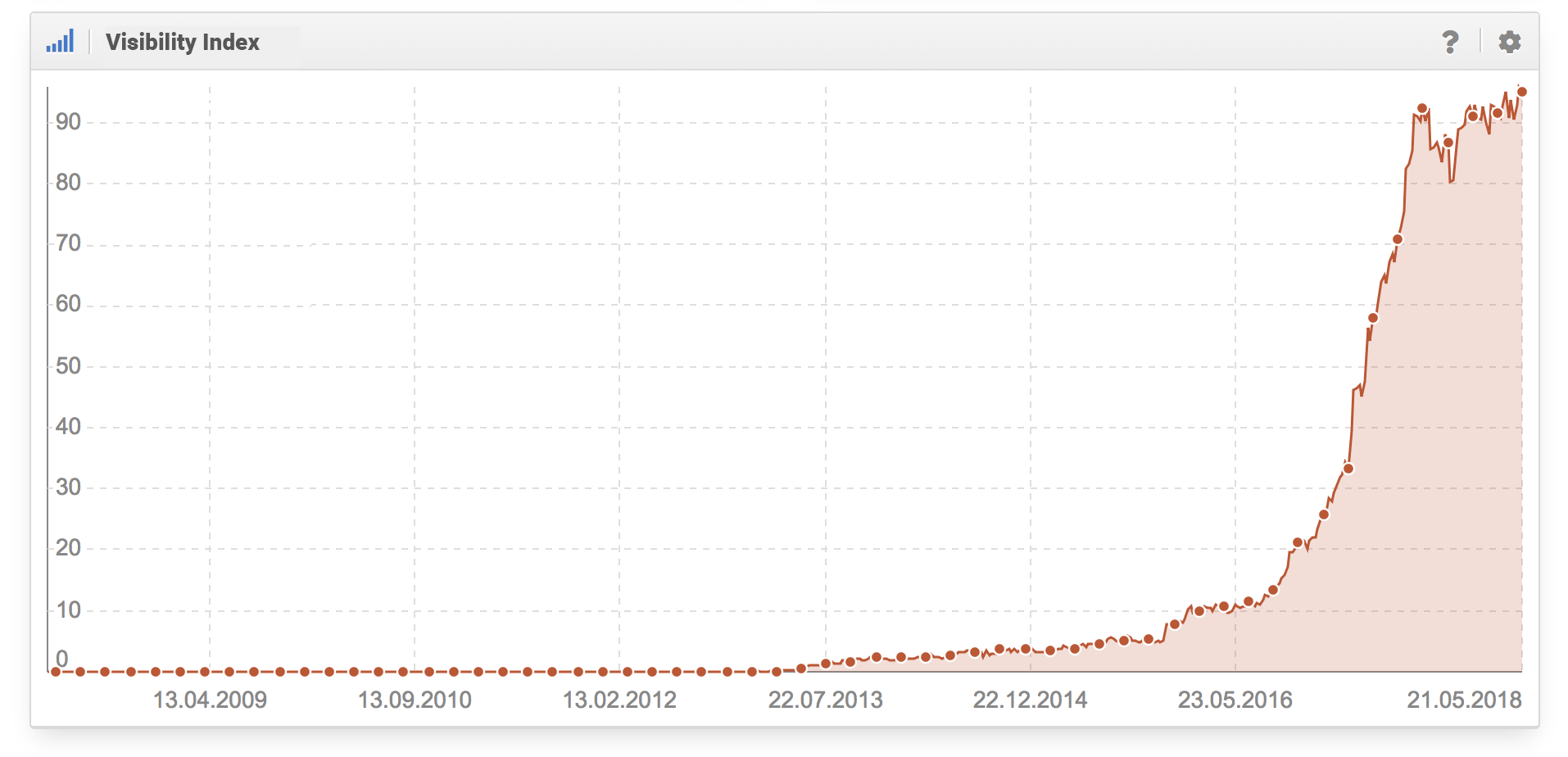

Si un sitio web grande es una marca conocida las búsquedas de marca generadas pueden proporcionar información interesante sobre el sitio web.

Aunque todos nuestros expertos coinciden en que a una marca fuerte no le afecta la investigación regular de palabras clave, puede valer la pena evaluar las búsquedas de marca.

Ésto se debe a que se puede relacionar la información sobre el contenido del sitio que los usuarios consideran que es específica de la marca. Además, las grandes empresas tienen la oportunidad de utilizar otros canales como puede ser la publicidad televisiva para generar un volumen de búsqueda de sus nuevas palabras clave. Para éstas ya han creado un entorno de mercado muy diferente al de las búsquedas genéricas.

Alex Moss

firecask.com

Todo depende de cómo se perciba la marca en público. Si la percepción no es consistentemente positiva, la investigación de palabras clave siempre debe considerar el tema de la «gestión de la reputación.

¿Cómo se organiza la asignación del material de palabras clave existente a los formatos y cómo se evita una canibalización de palabras clave de los formatos individuales entre sí?

En los sitios web grandes a menudo hay una gran cantidad de contenido y formatos de contenido. Cómo controlar la distribución de contenido en diferentes formatos, como blog, video, guías, para que no se canibalicen mutuamente es un tema clave.

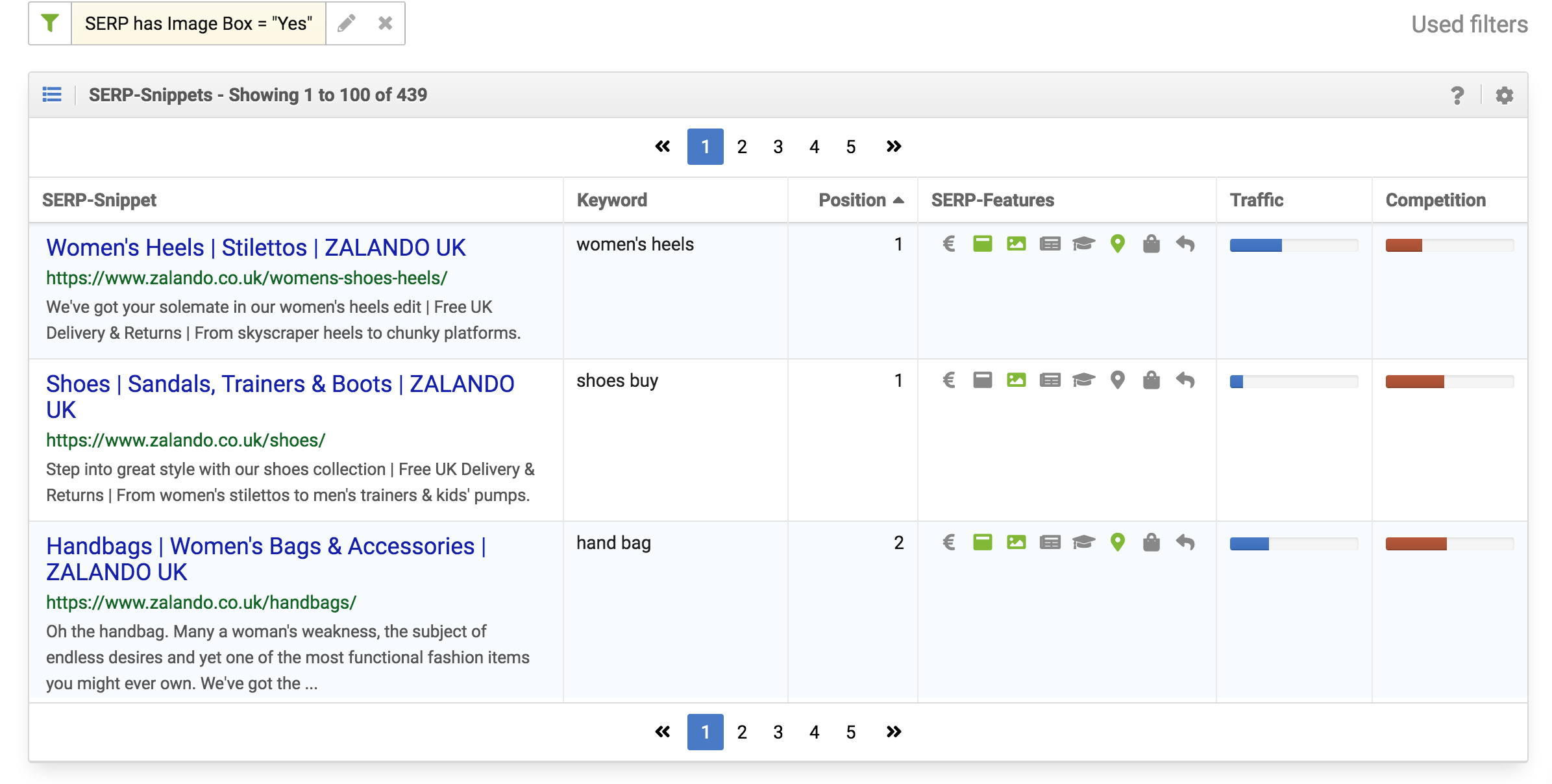

En la distribución se puede usar la intención del usuario. Al realizar una búsqueda Google muestra automáticamente los formatos que actualmente prefieren los usuarios. Esto se puede escalar mediante una evaluación de los SERP-Snippets de las palabras clave deseadas. De este modo se puede evaluar por ejemplo, para qué consultas los videos tienen una buena posición:

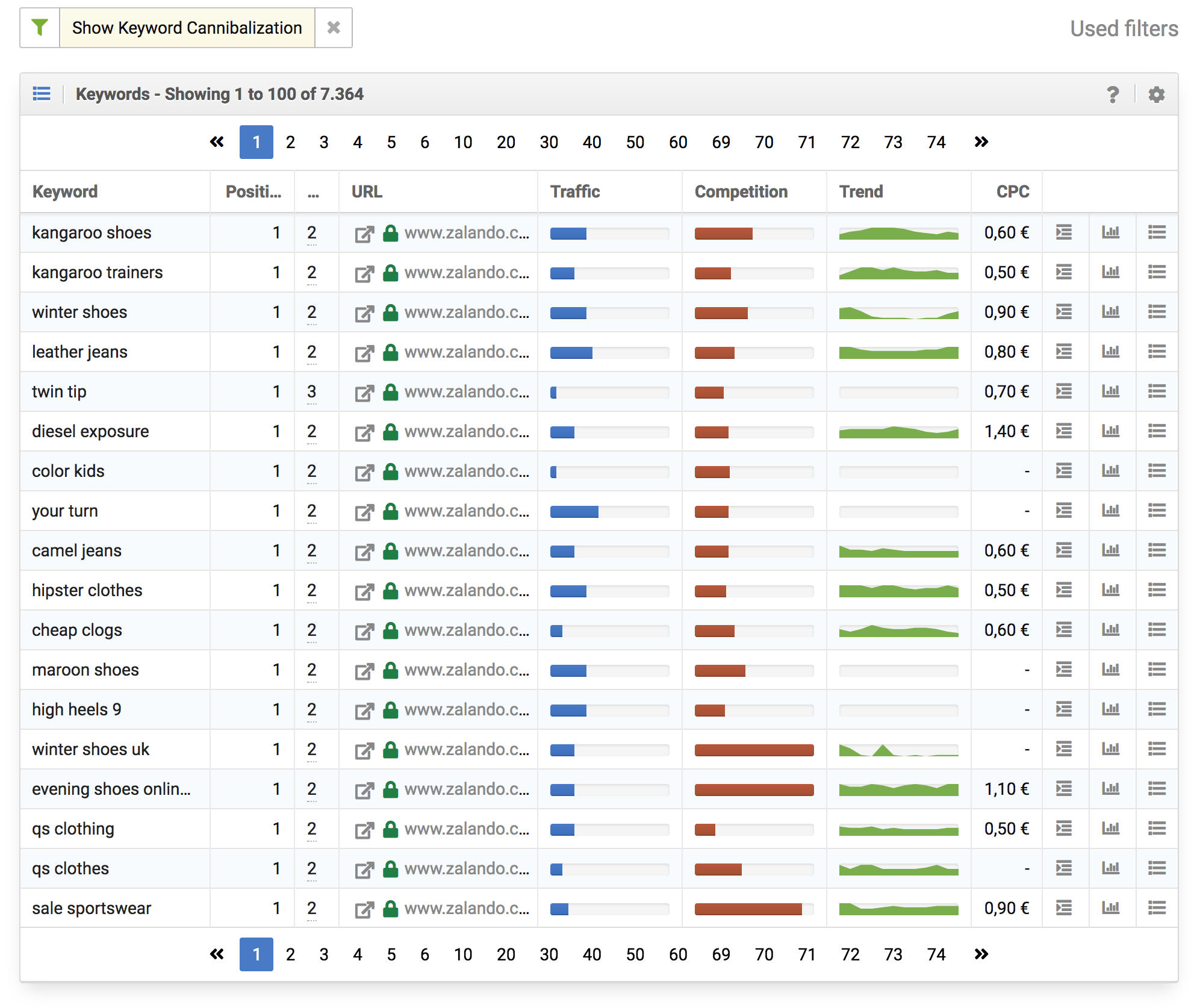

Para descubrir la canibalización se pueden usar herramientas útiles. Localizar las subpáginas que se alternan con las palabras clave en el ranking o en las que aparece más de una subpágina en los resultados. En estos casos, se debe decidir editorialmente qué subpágina proporciona el resultado más significativo para esa determinada búsqueda.

Carlos Redondo

safecont.com

In order to preven cannibalization, we sort our content from general to specific. If two results show up within one search, we will always prefer the general result.

Un paso efectivo de prevención de la canibalización es una estructura rigurosa y lógica en la arquitectura de la información del sitio. Un conjunto claro de reglas sobre cuándo se crean las páginas nuevas y dónde se ubican en la estructura impide que se creen contenidos similares de forma indiscriminada.

¿Cómo se puede escalar, descubrir y cultivar «Evergreen – Content»?

La gran ventaja de internet es que las publicaciones no se reimprimen constantemente, como en los periódicos diarios o semanales, y se crean muchos contenidos fragmentados sobre un tema.

Se pueden crear URLs individuales sobre el contenido que está continuamente disponible. Este contenido Evergreen ha demostrado ser una gran fuente de tráfico y confianza. Uno debe reconocer los formatos apropiados y expandirse.

Para identificar tu propio contenido Evergreen deberías usar tu propia herramienta de análisis web. ¿Qué temas podrían generar de manera continua o estacional flujos de tráfico fuertes durante varios años? Además, las herramientas de análisis se pueden utilizar para buscar URLs que se posicionen para muchas palabras clave en el top 10.

No solo debes centrarte en tu propio dominio para encontrar contenidos que resistan la prueba del tiempo. Además, se puede usar un Content-Gap-Analysis para analizar a la competencia, para la que se creó el contenido Evergreen.

En la creación de contenido ayuda tener un proceso claro en el que se verifica en el diseño de una página, si este es adecuado para el formato Evergreen. De nuevo, puedes trabajar bien con grupos de temas para encontrar publicaciones nuevas.

No importa si estás creando o desarrollando, debes darte cuenta de que la creación de contenido es siempre un proceso editorial y no puede ser generado por una máquina. La delegación es posible, pero solo se puede lograr a través de un equipo más grande.

Nedim Šabić

Freiberuflicher SEO-Berater

¡Escalable solo con personas para proporcionar valor agregado!

¿Qué tan importante es la búsqueda interna? ¿Qué se puede aprender de esto?

Ningún sitio web grande puede funcionar sin una búsqueda interna. La gama de sistemas, desde soluciones Out-Of-The-Box hasta las propias creaciones, es enorme y la calidad de las búsquedas es muy diferente. Sin embargo, hay una serie de argumentos importantes para destacar la búsqueda interna como una herramienta importante, principalmente para el usuario.

Solo ésto es motivo suficiente para invertir en una búsqueda interna. Desafortunadamente, los problemas en este contexto a menudo surgen debido a la falta de responsabilidad. Debe haber una persona de contacto clara en la empresa, que sea responsable de la búsqueda interna.

Kirsty Hulse

manyminds.digital

Para los usuarios que no desean hacer clic en las diferentes páginas de categorías individuales, la búsqueda interna es una función importante.

A partir de la información en la búsqueda interna, muchos departamentos pueden extraer ideas importantes. De modo que puedes encontrar páginas que son muy visitadas, pero que no son fáciles de encontrar desde una navegación habitual. También puedes ver lo que tus visitantes esperan de tu página web

Especialmente interesante: ¿qué buscan y esperan los usuarios de tu página web? Un análisis de todos los resultados de búsqueda para los cuales no se pudo mostrar ningún resultado proporciona información sobre las consultas de búsqueda en las que la página no pudo asignar correctamente un resultado a la intención de búsqueda del usuario.

Técnicamente, es importante mantener las páginas de resultados internos fuera de la Búsqueda de Google, ya que a Google no le gustan los SERPs en los SERPs.

¿Qué consejos tenéis para el A/B Test?

Probar sus propias hipótesis ha demostrado ser una buena manera, especialmente en la optimización de la conversión, en la que las decisiones pueden basarse no en la intuición sino en datos fiables.

En primer lugar, se debe hacer una distinción entre el A/B Test para la interacción del usuario (optimización de conversión) y los A/B Test de los factores de posicionamiento SEO. Los SEO A/B Test son difíciles porque muchos de los factores no se pueden descartar en la prueba. Cualquier tipo de interacción del usuario, por otro lado, debe probarse y con la mayor frecuencia posible.

Pedro Martinez

Unidad Editorial

Si no pruebas contigo mismo cómo Google reacciona a los cambios, nunca entenderás estos procesos. No temas el análisis de Logs ni a los Tests A/B, ésta es la única forma en que puedes mejorar.

En lo que respecta a la implementación de pruebas, debe definirse y estar disponible una persona fija de contacto durante toda la prueba. Se ha demostrado que las implementaciones antes del fin de semana y las vacaciones a menudo causan problemas que no se pueden resolver directamente.

La mayoría de los proveedores y Frameworks trabajan mucho en JavaScript. Los A/B Test teóricamente tienen el potencial de cambiar todo el sitio web y también dispararlo. Esto hace que sea importante monitorizar bien la prueba para detectar con anterioridad si hay algún problema en la página web.

Por lo tanto, es conveniente tener un freno de emergencia del que se pueda tirar para detener la prueba y expandir el código, sin que IT o el proveedor externo tengan que responder.

Para evitar posibles problemas de contenido duplicado, la versión actual A (hipótesis nula) siempre se debe especificar como una versión canónica. A los motores de búsqueda siempre se les puede enviar a esta versión a través de una consulta de User Agent.

¿Qué condiciones se deben cumplir en los sitios web grandes para que sea posible una internacionalización con Hreflang?

Con el etiquetado Hreflang Google ha creado una forma de vincular lingüísticamente subpáginas diferentes pero relacionadas a nivel de contenido y de hacer a los motores de búsqueda esta vinculación comprensible. Aunque Hreflang viene con reglas relativamente simples, se puede acabar cometiendo errores.

Vale la pena estudiar los requisitos para el uso en Google del atributo Hreflang precisamente porque, además de muchos posibles obstáculos técnicos, a menudo también hay errores conceptuales.

La primera condición es un sistema interno que conozca la relación de los contenidos entre los diferentes idiomas. Ésto incluyen direcciones URL y números de artículos, especialmente si hay diferencias por cada país.

Markus Hövener

bloofusion.de

El requisito básico para las etiquetas hreflang correctas es una estructura idéntica de las distintas páginas por países.

Hay muchas maneras de usar parches auxiliares para que Hreflang funcione en una página. Sin embargo, solo una implementación técnica limpia puede implementar los cambios posteriores, así como las páginas e idiomas nuevos sin una sobrecarga general.

¿Cómo se mantiene la visión general y cuando se desciende a nivel de palabras clave individuales?

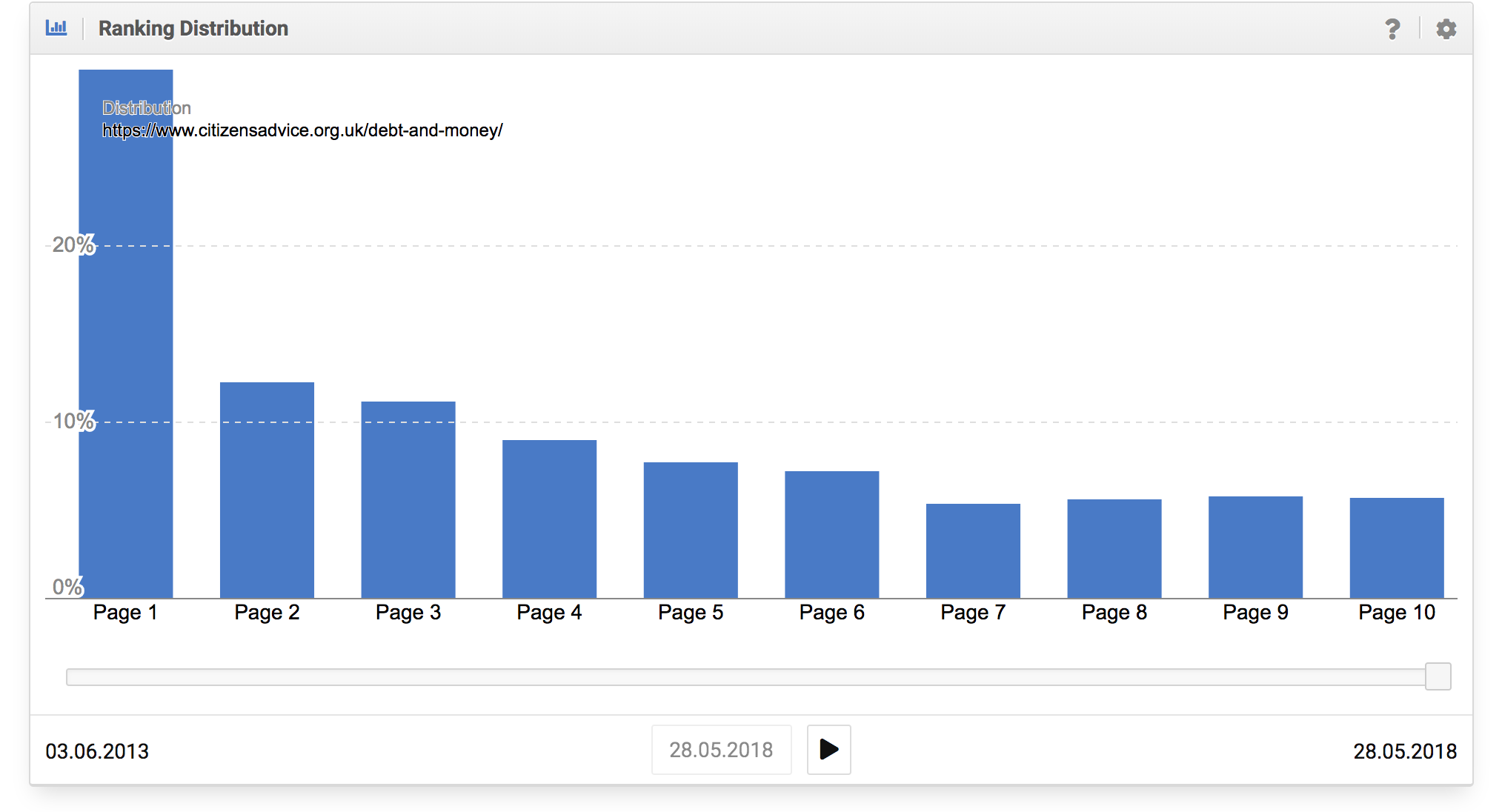

Incluso con unas pocas decenas de miles de páginas ya no es práctico ejecutar evaluaciones para cada subpágina. Con cientos de miles o millones de páginas es aún menos práctico.

En el caso de sitios web muy extensos vale la pena configurar alertas automáticas para las evaluaciones internas que rechacen una desviación de la norma. No se trata de entrar en pánico en cada erupción, pero es extremadamente útil para detectar tendencias.

Daniel Pinillos

FunnelPunk.com

Para monitorear el éxito de un proyecto grande de la manera más eficiente posible, se recomienda monitorear grupos de palabras clave completos: para cada Landingpage, subpágina o página de producto.

Estas tendencias, ya sean negativas o positivas, pueden analizarse en detalle e identificar las causas.

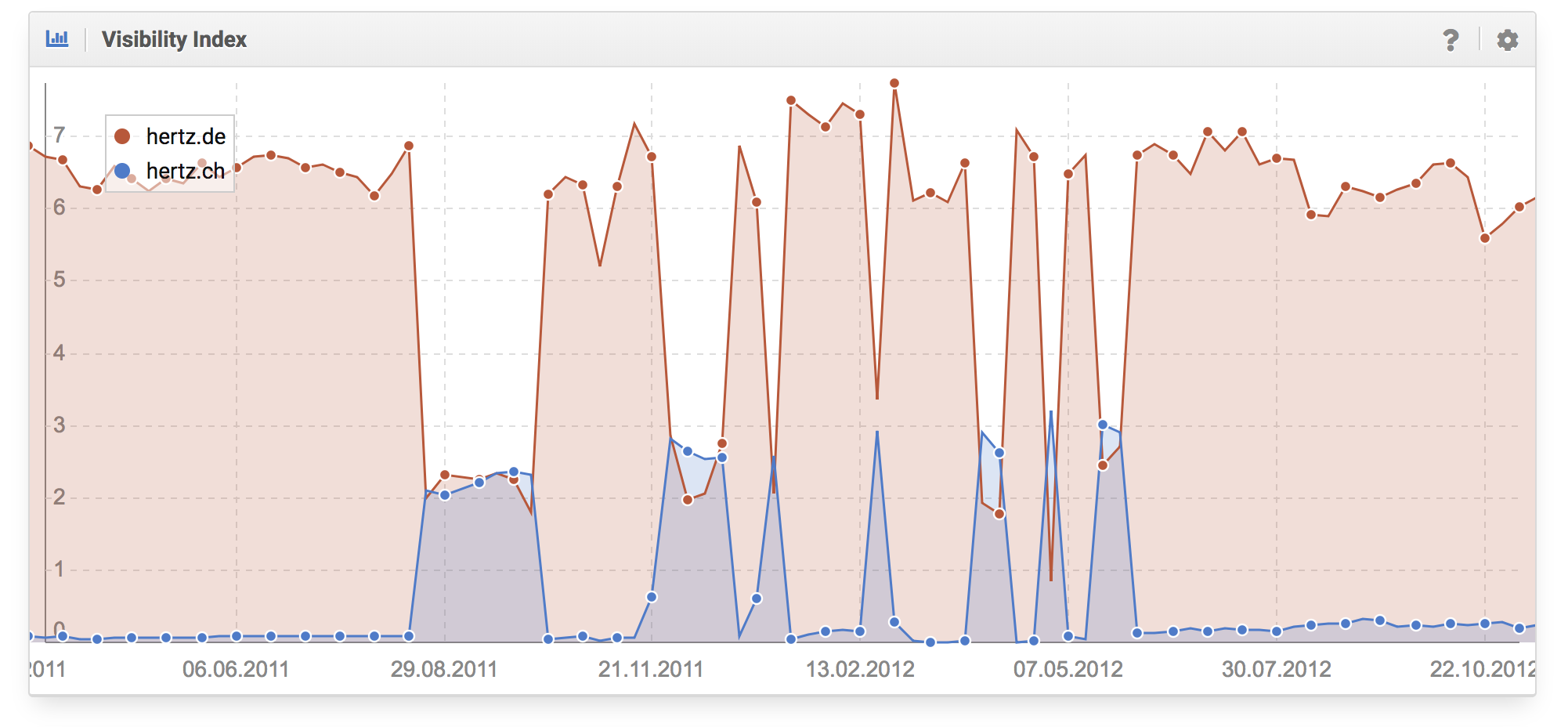

A efectos generales, los índices pueden ser muy útiles, especialmente cuando se trata de evaluar posibles actualizaciones de Google, utilizando una amplia variedad de ejemplos. Además, es aconsejable controlar tu propio conjunto de palabras clave, que se puede usar para cubrir áreas, temas o nichos completos.

Prueba SISTRIX gratis

- Cuenta de prueba gratuita durante 14 días

- Sin compromiso. No necesitas cancelarla.

- Onboarding personalizado con nuestros expertos.