¿Qué tienen un común la página de resultados en Google y el anaquel de un supermercado?

- Tienen una función específica.

- Tienen un espacio limitado disponible (restricción)

En ambos casos, la restricción es el factor limitante para el desempeño de todo el sistema. El supermercado podrá ganar más dinero con más espacio en el anaquel, así como podrá ofrecer una gran variedad de productos para satisfacer las necesidades de los compradores. De igual forma, Google podría ofrecer más de 10 resultados orgánicos en la primera página de resultados de búsquedas (Searcher Satisfaction).

Google y el supermercado tienen el mismo problema de escoger los productos para su espacio limitado. Mientras que, el proceso estándar de un supermercado, es bien conocido como lo básico en la administración de negocios, pero, cuando se trata de Google, son solo conjeturas y confusión. A raíz de esto, es buena idea observar la selección de opciones que tiene que hacer un supermercado. Quizás haciéndolo, podríamos aprender un poco acerca de cómo Google escoge sus resultados.

¿Por qué Google no muestra más de 10 resultados?

A primera vista, la solución más simple para incrementar la satisfacción de sus usuarios sería que Google mostrara más de 10 resultados orgánicos por página de resultados del buscador (SERP). Google les preguntó a sus usuarios sobre qué pensaban de estar idea y obtuvieron que los usuarios querían más resultados. Después de todo, más es más.

De acuerdo a la antigua vicepresidente, Marissa Mayer, Google llevó a cabo una prueba con 30 resultados por SERP. La versión con 30 resultados mostró una disminución en tráfico y ganancias por un 20% comparado con la versión con 10 resultados. ¿Cómo es posible?

Google necesita 0.4 segundos para crear y mostrar un SERP con 10 resultados. Por otro lado, la página con 30 resultados tomó 0.9 segundos en cargas. Esta diferencia de 0.5 segundos eliminó la satisfacción del usuario y llevó a una restricción que les costó un 30% de tráfico. Hasta este día, Google solo mostrará 10 resultados orgánicos por página gracias a este experimento.

El supermercado tiene el mismo problema. En teoría, ellos simplemente pudieran añadir más anaqueles. Pero esa medida podría reducir los pasillos para los clientes y tendrían un fuerte efecto negativo en toda la experiencia de compras. Esto significa que los productos en un supermercado es limitado a un monto específico de espacio en el suelo.

Problema: Optimizar el espacio de anaqueles de un supermercado

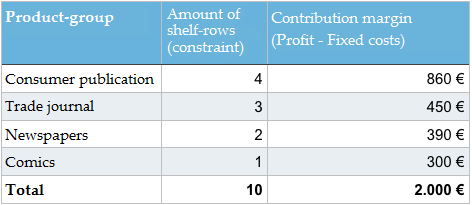

Ahora que identificamos la restricción, podemos observar un simple ejemplo. Asumamos que tenemos un anaquel específico en un supermercado para periódicos y revistas. El anaquel hecho con 10 filas las cuales pueden ser utilizadas para los productos antes mencionados. El gerente del supermercado tiene la siguiente información a su disposición.

Gráfica: Información para la optimización del espacio del anaquel en el supermercado

Nota: voy a pedirle a nuestros lectores que me disculpen por utilizar el término de economía “margen de contribución” en lugar del término colocar “ganancias”. No puedo evitarlo. Explicación: ganancia = margen de contribución – costos fijos (alquiler, costos del personal, etc.).

¿Cómo debería el gerente del supermercado organizar los periódicos y revistas con el fin de maximizar el margen de contribución? ¿Debería haber un cambio en los productos disponibles? ¿Llegaste a una solución al problema?

Solución al problema

La solución es muy simple, si has analizado lo básico de la optimización con restricciones. Todo el sistema debe ajustar con la finalidad de utilizar la restricción de mejor manera, en este caso, el espacio disponible del anaquel.

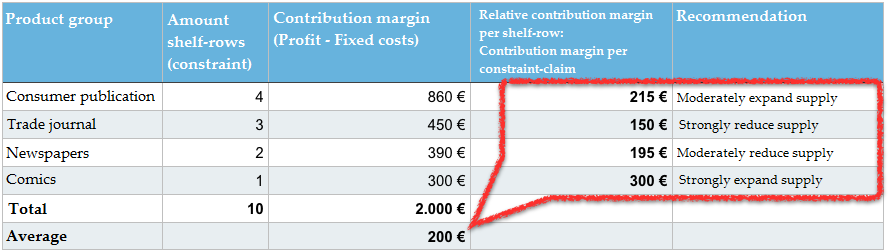

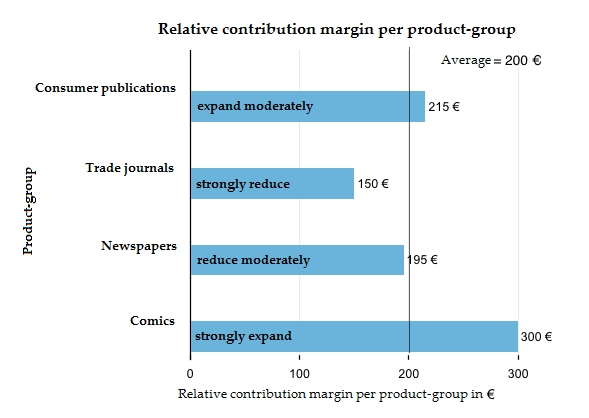

El margen de contribución por cada grupo de productos se ha divido por el número de las filas del anaquel ocupadas, como resultado al margen de contribución relativo por cada grupo de producto. La organización de los grupos con un margen relativo de contribución de >200 € es ampliado y el grupo de productos con un margen relativo de contribución de <200 es reducido.

Nuestro indicador más importante aquí no es el margen de contribución por cada grupo de productos de la tabla 1 (publicaciones para el consumidor, revistas especializadas, etc.). Con el fin de optimizar el anaquel, necesitamos un margen de contribución por restricción (margen de contribución relativo por cada fila del anaquel). Por lo tanto, no preguntamos por el margen de contribución total de todos los grupos de productos, pero queremos saber cuánto margen de contribución logramos generar de los espacios del anaquel en uso. Para eso, dividimos el margen de contribución de cada grupo de productos por el número de filas ocupadas en el anaquel y obtenemos el margen relativo de contribución. Todos conocemos este principio de nuestras evaluaciones de marketing online, cuando trabajamos con indicadores como el Click-Through-Rate (CTR) y tomamos en cuenta el número de clic en relación reclamo de restricción (impression).

En promedio, 10 filas del anaquel generarán un margen de contribución de 200€ (2.000 € MC: 10 filas). Las revistas especializadas solo logran generar 150 EUR por cada fila. Esto hace que sea el grupo de productos que genere menos ganancias. Mientras que son el segundo grupo de productos con el mayor margen de contribución general, por detrás de las publicaciones para el consumidor con un 450 EUR, también ocupan hasta tres filas completas y por lo tanto un 30% de nuestra restricción y solo generan el 22,5% del margen de contribución. Estamos seguros que darle un mejor uso al espacio del anaquel de forma más eficiente.

Los comics solo generarán un margen de contribución general de 300 EUR, pero tan solo ocupan una de las filas del anaquel. Debido a esto, son el grupo de productos con el mayor ganancia con un margen de contribución relativo de 300 EUR.

Ahora podemos averiguar qué debemos optimizar. Debemos reducir todos los grupos de productos con un margen relativo de contribución menor al promedio (< 200 EUR) y en su lugar llenar los espacios con aquellos grupos de productos con logren tener un margen relativo de contribución por encima del promedio (> 200 EUR).

En nuestro ejemplo, el gerente del supermercado debería utilizar menos espacios del anaquel para las revistas especializadas, periódicos, y experimentar utilizando el espacio libre para comics y publicaciones para consumidores. También podría generar ganancia introducir un nuevo grupo de productos, como los libros de bolsillo, por ejemplo. El objetivo a largo plazo es el de incrementar el promedio del margen de contribución por cada fila del anaquel.

No existe una solución exacta a este problema, ya que desconocemos el margen de beneficios de los grupos de productos. El gerente no sabe si incrementar los comics por 10%, 50% o 100%. Solo conoce donde debe hacer los cambios. No tiene más opción que realizar pruebas hasta encontrar la solución óptima. Una vez que haya cambiado el grupo de productos disponibles y el espacio relativo, puede volver a comenzar una nueva ronda de pruebas.

En la vida real, este proceso de decisiones es mucho más complejo, debido a que existe más información, datos y opciones disponibles. Decidimos mantener este ejemplo lo más simple.

¿Cómo se traduce la optimización de espacios en los anaqueles a Google?

El principio de la optimización con restricciones, también llamado Theory of Constraints es un método económico, práctico y exitoso muy conocido. No solo lo utilizan los minoristas para averiguar cómo aprovechar mejor su espacio disponible de ventas, sino también a través de todos los puestos administrativo (producción, mercadeo, administración de la cadena de suministros, financias, controlador, gestión de proyectos, etc.).

La imagen del modelo tipo embudo para ilustrar el teorema principal de la Theory-of-Constraints: “En cada valor de la cadena existe un sistema que determina el desempeño del mismo, una restricción distinta”.

No sería muy sorprendente si Google decide de no reinventar todo el mecanismo y aplicar este principio básico en la manera en que escoge sus resultados de búsquedas. Existen varios aspectos a favor de esta teoría. Antes de adentrarnos más en este tema, tenemos que tomar un desvío y leer información adicional sobre cómo funcionan la búsqueda y clasificación de Google.

Google no puede evaluar cada resultado por cada petición de búsqueda

John Wiley, Diseñador en Jefe en Google Search, dijo en 2013 que apenas 15% de todas las peticiones de búsquedas diarias son nuevas y nunca habían sido solicitadas a Google. Esto corresponde a un estimado de 500 millones de peticiones de búsquedas por día. Para estas peticiones, Google no posee información sobre cuáles resultados fueron calificados por los usuarios como los más útiles y cuáles cumplieron el propósito de Searcher Satisfaction de los usuarios (el objetivo de satisfacer al usuario).

Solo podemos calcular cuántas peticiones de búsquedas de Google han sido solicitadas en tan pocas ocasiones que Google no posee mucha información para el fin de evaluar cada resultado. No nos sorprendería si este número resultara estar entre 30% y 60% de todas las peticiones de búsquedas.

Incluso si Google pudiera determinar si un resultado puede ser relevante para una petición de búsqueda específica utilizando un análisis OnPage, lo que no puede hacer es definir si el resultado será satisfactorio para el usuario. Debido a esto, Google se ve obligado a evaluar otras señales con el fin de obtener una buena predicción de la calidad del resultado.

Las señales de enlaces son muy importantes, pero tienen sus limitaciones

Una vez que hayan averiguado todos los documentos que puedan ser considerados para una petición, luego utilizarán el fundamento principal de Google, el algoritmo de PageRank. Este es un procedimiento para evaluar un número de documentos unidos por la estructura de sus enlaces. Cada SEO sabe lo importantes que son los enlaces en las clasificaciones de Google.

El algoritmo de PageRank trabaja muy bien y ha hecho que el motor de búsqueda de Google sea el líder en el mercado en muy poco tiempo. Aunque este concepto tiene sus límites.

Hay pocas señales disponibles para las páginas individuales

Google tiene conocimiento de más de 60 mil millones de páginas individuales. La gran mayoría de estos documentos (URLs) en la World Wide Web no poseen enlaces de página externas hacia ellos. Un dominio como eBay.de actualmente tiene más de 30 millones de URLs diferentes dentro del índice de Google. Es muy probable que solo una fracción de estos URLs tenga enlaces externos, considerando que muchos de estos URLs se vuelvan obsoletos una vez que la subasta haya finalizado. Lo mismo sucede con la mayoría de las páginas web.

Para recibir datos de enlace por cada URL individual, Google hace un esfuerzo a gran escala para también tomar en cuenta enlaces internos de un dominio. El problema es que los enlaces solo son de fiar hasta cierto punto, dado que estos enlaces internos son enteramente controlados por los operadores del sitio web.

Al mismo tiempo, podemos agregar que también los enlaces externos solo son de fiar hasta cierto, dado que estos, han sido manipulados a través de enlaces pagos a lo largo de los años.

Google evalúa la calidad del dominio entero

Google es capaz de mitigar parte del problema de tener datos insuficientes para URLs individuales, al averiguar la calidad del dominio correspondiente. Usar la suma de todas las señales para el dominio, incluyendo todos los URLs, le permite a Google obtener datos mucho más concretos cuando se evalúa una fuente específica.

Es lógico que Google hable de “(sitio) web y calidad de página” cuando explican cómo funciona su clasificación.

En los círculos SEO, al referirnos a la clasificación de Google de un dominio entero, hablamos de Domain Trust o Domain Authority, al evaluar el dominio para un tema específico, como “salud” o “deportes”.

Nuestro gerente de supermercado antes mencionado tiene problemas similares. Cuando llega el momento de tomar decisiones sobre la clasificación de los productos, es simplemente imposible probar y evaluar de forma individual cada revista y publicación. Y luego está el hecho de que, incluso de una publicación a otra, puede haber un cambio en la calidad dentro del producto. Nuestro gerente de supermercado tiene que depender de la simplificación de estas estructuras complejas, combinando publicaciones individuales en grupos de productos, como publicaciones de consumidor y revistas de comercio. Entonces, estos grupos de productos pueden ser analizados y su desempeño puede ser comparada con los demás.

Google también evaluará el comportamiento del usuario

Se toma prácticamente por un hecho, dentro de los círculos SEO, que Google no solo evalúa los enlaces, sino que también irá un paso más allá y echará un vistazo al comportamiento del usuario. Usando los datos de enlace, es posible tener un primer conjunto de resultados, los cuales son tan confiables y relevantes como es posible, para los 10 mejores.

Google logrará resultados de búsqueda mucho mejores si también analiza la manera en que los usuarios interactúan con estos resultados, lo cual puede hacer que reorganicen los resultados de búsquedas.

No sería lógico ni conveniente tener siempre un resultado en la primera posición, si los usuarios, por lo general, prefieren los resultados desde la posición 2 hasta la 10. También, sería ilógico, tener siempre un resultado entre los 10 mejores, si los usuarios raramente interactúan como él. Por no mencionar que, cuando se trata de eventos actuales y los así llamados temas calientes, los enlaces que crecieron históricamente a lo largo de los años no tienen ningún uso. Cuando las clasificaciones se reorganizan, hablamos de un reranking, para el que Google ha archivado una serie de especificaciones de patentes, donde encontrarán más detalle sobre las ideas de Google, si están interesados.

Las señales de usuarios pueden tomar en consideración aspectos como la calidad del contenido, utilidad del sitio web y preferencias del usuario (por ejemplo, para marcas). Cada vez que exista alguna duda, pueden estar seguros de que el “voto” del usuario puede ser considerado más valioso que simplemente confiar en un dato de enlace. Aun así, los datos de enlace son importantes para que el sitio sea una de las elecciones, cuando se trate de un voto.

¿Qué datos usa Google para evaluar el comportamiento de los usuarios?

No se sabe qué datos de comportamiento de usuario evaluará Google específicamente para la clasificación, o reranking. Tampoco sabemos la definición exacta de cómo Google determina la Searcher Satisfaction y como evaluarán los resultados individuales, basados en el comportamiento del usuario. Es posible que usen métricas tales como CTR, clickstream-data, time-on-site y la proporción del return-to-SERP, por nombrar algunas, y todas estas métricas se originarían de CTR.

Otra posible fuente de datos para la evaluación podría ser el navegador web, Chrome, de Google, el cual almacena datos para casi cualquier dominio. Menos probable es el uso de datos de Google Analytics, por una parte, dado que los datos de Analytics solo estarían disponibles para dominios que utilicen Google Analytics, los cuales son apenas el 10% de todos los sitios web, de acuerdo con datos de buildwith.com. Este porcentaje podría de hecho ser mayor para sitios web grandes y conocidos.

Por otra parte, al usar los datos de Analytics pondría a Google en un compromiso de credibilidad, ya que siempre han afirmado públicamente que no usan datos de Analytics para las clasificaciones. Actualmente, el navegador Chrome tiene un porcentaje de uso mundial de más de 40% de acuerdo a los datos de StatCounter. Esto debería permitirle a Google obtener datos de uso para casi todos los sitios web en el mundo. Cuando se trata de decidirse por una fuente de datos, Chrome sería una alternativa mucho más útil que Analytics.

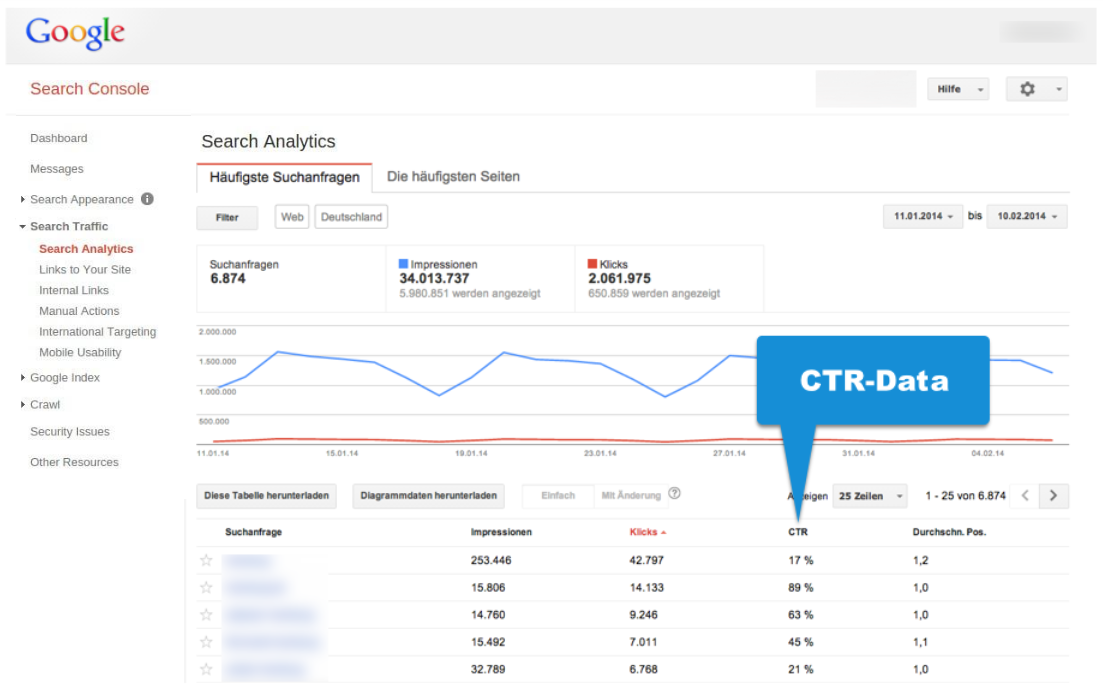

Además, Google, por supuesto, tiene acceso directo a los datos de Google Search. Podemos estar absolutamente seguros de que estos datos son rastreados y evaluados, dado que Google les mostrará el CTR para peticiones de búsquedas individuales y URLs dentro del Google Search Console.

Observemos un ejemplo donde diremos que Google evalúa la “cantidad de satisfacción” a través del CTR, en aras de la simplicidad. En realidad, esta evaluación de seguro será mucho más compleja y mejor pensada.

En nuestro ejemplo simplificado, el CTR sería el equivalente del Google-Search, como el margen de contribución relativo de nuestro ejemplo del supermercado. El CTR ya tomará en cuenta la restricción de reclamo. El valor para el número de clics es considerado en relación a las impresiones (restricción).

Los límites de los datos CTR

Como ya mencionamos previamente, para la mayoría de los sitios web no hay casi datos disponibles para páginas individuales. Y esto no solo funciona para los datos de enlace, sino también para los datos CTR.

Podemos observar esto fácilmente dentro del Google Search Console, si echamos un vistazo a los datos CTR. Relativamente pronto, llegaremos al punto donde Google solo mostrará valores de “clic” por debajo de 10 en la lista de palabras claves y URLs individuales.

Los datos que ven en el ejemplo de arriba, que provienen de un dominio grande que evaluamos para este artículo, con más de 34 millones de impresiones SERP y más de 2 millones de clics al mes, muestran un valor de menos de 10 clics mensuales, de aproximadamente 50% de las búsquedas. Debemos tener en cuenta que Google solo nos mostrará las búsquedas más populares. En este caso, solo se nos mostraron 6 de los 34 millones de impresiones SERP, lo cual es cerca del 18%. Cuando se trata de la gran mayoría de búsquedas, Google simplemente no tiene datos confiables de los resultados para un dominio individual.

En definitiva, está claro que los datos CTR solo pueden suministrar información, la cual es al menos actual, para búsquedas relativamente populares, sin importar los valores CTR exactos. Esto significa que los datos CTR, al igual que los datos de enlace, al final dará con un muro para una gran cantidad de peticiones de búsquedas.

¿Cómo evaluará Google los datos CTR para el dominio completo?

Tendría sentido si Google considerase que los datos CTR para el dominio completo, (o más bien una definición de «Searcher Satisfaction» mucho mejor pensada pero desconocida para nosotros). Este indicador podría, entonces, ser parte de la métrica global del «Domain Trust».

La idea subyacente es muy simple. Si el dominio entero crea una cantidad mayor al promedio de «Searcher Satisfaction», entonces será posible seguir incrementando la Searcher Satisfaction a través de todas las búsquedas de Google al mostrar resultados relevantes del dominio que sean más prominente para más solicitudes de búsquedas.

Las razones reales por las cuales los usuarios pueden referirse a resultados de dominios específicos como más satisfactorios que otros (de dominios con un grado similar de relevancia) pueden ser muchas. El nombre del dominio, preferencias de marca, tiempo de carga, calidad del contenido, estilo del lenguaje, usabilidad, avisos publicitarios no invasivos, calidad de optimización y confiabilidad percibida son solo algunos de los criterios que pueden desempeñar algún papel y los cuales serán evaluados a través de las interacciones conscientes e inconscientes de los resultados.

Si seguimos la línea de pensamiento, entonces estaría dentro del espíritu de la teoría de las restricciones el permitir a estos dominios, con un CTR por encima del promedio, más visibilidad (impresiones SERP) dentro de los SERPs. De igual modo, las impresiones SERP para un dominio con una cantidad de datos CTR por debajo del promedio, serán reducidas hasta que alcancen la cantidad del promedio.

Esta estrategia sería adecuada para el incremento de la Searcher Satisfaction en general, al igual que el gerente del supermercado de nuestro ejemplo puede implementar el margen de contribuciones para su anaquel, al incrementar la cantidad de grupos de productos económicos por encima del promedio.

La visibilidad de un dominio se moverá en tendencias

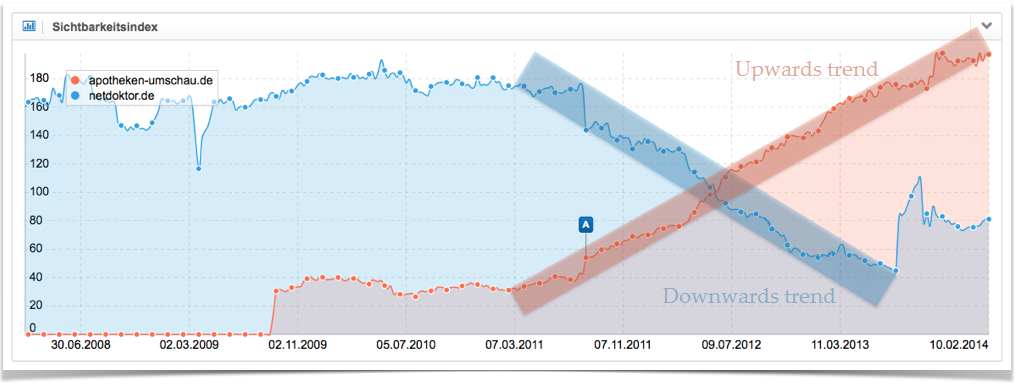

La visibilidad de un dominio, por lo general, no irá en línea recta, sino que está sujeta a altos y bajos constantes. Esto causará que el índice de visibilidad muestre una serie de picos y bajadas, cuya dirección definirá la tendencia. Hablaremos acerca de una tendencia ascendente, si podemos ver un número de picos y bajadas sucesivamente más altos. Por el contrario, hablaremos de una tendencia en descenso, si vemos una serie de picos y bajas sucesivamente más bajos. Si tenemos una serie de picos y bajadas de aproximadamente la misma altura, hablaremos de una tendencia lateral. Pueden encontrar explicaciones más detalladas sobre estas tendencias en nuestros videos.

El siguiente gráfico muestra dos tendencias muy distintas para dos sitios web alemanes, las cuales se manifiestan por un largo periodo de tiempo. En rojo, tenemos la tendencia ascendente para el dominio apotheken-umschau.de y la tendencia descendente para netdoktor.de en azul.

El modelo de “optimización de espacio en anaquel” que presentamos, sería adecuado para explicar estas tendencias. Un dominio con valores de Searcher Satisfaction por encima del promedio obtendrá más y más visibilidad, un paso a la vez. Está permitido utilizar la restricción de “impresiones SERP” con mayor fuerza. Esto continuará hasta que las impresiones del dominio en los resultados de búsqueda disminuyan más y más, y el dominio tenga valores promedio de Searcher Satisfaction.

Si un dominio genera números por debajo del promedio, perderá visibilidad y podría utilizar la restricción en una escala menor.

Además hay, por supuesto, otros factores que dejarán su marca en la visibilidad del dominio, como desarrollo de enlaces, creación de contenido, optimizaciones SEO progresivas, rediseños del sitio web, actualizaciones de Google y muchas más.

¿Qué significa esto en la vida real?

Tenemos que ser muy claros: este modelo de “optimización de espacio en anaquel” para Google es simplemente un constructo teórico, el cual no ha sido probado en ninguna parte. Aunque, para entender mejor ciertos desarrollos, es muy útil tener en cuenta un modelo funcional de cómo trabaja el algoritmo de Google. Si creen que es un modelo factible, entonces tenemos dos palancas principales que podemos usar en el mundo real.

- Optimizar el desempeño: todas las medidas exitosas que incrementan el Searcher Satisfaction para un dominio específico aumentarán la visibilidad del dominio a través de un incremento en sus clasificaciones.

- Optimizar el reclamo de restricción: cada pieza de contenido indexado con un Searcher Satisfaction por debajo del promedio, disminuirá el desempeño general del dominio y, por lo tanto, reducirá la futura visibilidad que el dominio tendrá en los resultados de búsquedas de Google. Por ello, no deberían siquiera mostrar estas páginas con mal desempeño a Google (

<meta name="robots" content="noindex">). Deberían tratar de solo páginas con gran desempeño compitiendo por las “impresiones” de restricción, para obtener un pedazo mayor del pastel de los reclamos de restricciones de Google, en el futuro.

Mientras que las optimizaciones de desempeño ven un constante flujo de charlas y artículos, apenas oímos algo de las optimizaciones para reclamos de restricción. Específicamente, esto significa decidir cuáles piezas de contenido dejan que Google indexe y cuáles no. Muchos SEOs experimentados les dirán sus observaciones acerca de que puede ser un enorme impulso para sus clasificaciones el hecho de solo tener contenido verdaderamente único y útil dentro de las páginas del índice y retirar del índice aquellas páginas con una calidad de contenido pobre. Estas observaciones también se pueden explicar a través de nuestro modelo de “optimización de espacio en anaquel”.

Nueve consejos para optimizar los reclamos de restricción en la vida real

Por último, queremos darles nueve consejos para optimizar las “impresiones SERP ” de los reclamos de restricción.

- Comprobar regularmente los datos CTR en el Google Search Console. Deberían conocer tanto los puntos débiles como los fuertes de tu dominio en lo que respecta al CTR.

- Una vez que conozcan sus fortalezas, creen más contenido de este tipo.

- Para páginas y búsquedas con poco CTR, consideren si la página está optimizada para la frase de búsqueda correcta. Su página puede tener gran contenido, pero puede que esté apareciendo por la solicitud de búsqueda errónea, debido a las señales incorrectas. Echen un vistazo a los resultados (título, descripción, URL) y al contenido de otros sitios web en los mejores 10 puestos en busca de la palabra clave y traten de averiguar si podrían tener una mejor respuesta para la solicitud de búsqueda. Pónganse en la posición de quien busca e intenten entender sus necesidades.

- Fijen esos datos con malos datos CTR y contenido sin ningún tipo de valor agregado notorio en NoIndex, para fortalecer el resto de sus páginas.

- Es incluso mejor si son capaces de identificar grupos enteros de páginas que puedan fijar en NoIndex sin tener que preocuparse. Por favor, piensen dos veces, ¿realmente necesitan pasar por todo el proceso de filtrado y clasificación de páginas en una tienda en el índice? En zalando.co.uk, por ejemplo, Google se permite indexar el sitio “zapatos de negocios para hombres” y los resultados filtrados “zapatos de negocios negros de cuero para hombre”, por otra parte, están fijadas en NoIndex, dado que esta característica no se busca tan a menudo y la selectividad de los otros dos filtros se perdería. ¿Es razonable para un directorio de páginas amarillas tener todas las 3.500 categorías de una aldea pequeña indexada, incluso si hay menos habitantes que categorías? ¿Pertenecen realmente al índice las páginas con contenido desactualizado, como anuncios publicitarios expirados? Puede ser muy útil tener un separador lógico y tangible para su estrategia de indexación, para no saturar las restricciones con contenido de baja calidad.

- User-Generated-Content (UGC) es económico y por lo tanto genial, aunque la calidad y el valor agregado sean usualmente mediocres. Esta es la razón por la que los foros de Preguntas y Respuestas crean señales de usuario, por lo general, negativas. Aquí, deberían introducir un sistema eficiente para asegurarse de que solo el contenido valioso es indexado. Esta selección puede o bien suceder a través de un equipo editorial o automáticamente a través de un sistema de clasificaciones, por ejemplo, donde los usuarios puedan votar en la calificación de contenido.

- Sin importar cómo defina Google el Searcher Satisfaction, los valores CTR son probablemente una parte de ello. Pueden incrementar el CTR a través de un diseño orientado a metas de sus resultados (título, descripción, URL). Un resultado debería comunicar relevancia, valor agregado y una llamada a la acción. Además, mantengan el principio AIDA en mente, cuando diseñen la meta descripción.

- Echen un vistazo al número de páginas indexadas y exploren las posibles razones de los grandes cambios, para que puedan tomar contramedidas, de ser necesario.

- Eviten el contenido duplicado.